-NAT Traversal로 유휴 PC 연결…오토스케일링로 자원 자동 할당해 비용 낮춰

-AI 모델의 안정적 운영, 성능 최적화, 비용 효율화를 위한 자동화된 운영 인프라 제공

-파일럿 테스트 마치고 내년에 서비스 정식 론칭…2026년 상반기 시리즈 A 투자 유치 추진

AI 서비스 구현의 핵심은 학습(Training)과 추론(Inference)이다. 학습이 AI 모델이 대규모 데이터에서 패턴을 인식하고 연관성을 파악하도록 모델을 훈련하는 과정이라면, 추론은 학습된 모델이 사용자의 질문에 답변을 생성하며 실제로 서비스가 운영되는 과정이다.

AI 서비스를 하려면 대규모 데이터 세트와 고성능 컴퓨팅이 필수적이다. 수천 개에서 수만 개의 GPU를 배치하고, GPU 간 통신을 최적화하기 위한 고대역폭 네트워크를 갖춘 데이터센터를 운영해야 한다. GPU는 대당 1,500만 원 이상하며, 2,000만 원을 초과하기도 한다. 이처럼 막대한 인프라 비용, 특히 고가의 GPU 구매와 운영 비용이 AI를 서비스하는 대부분의 기업이 수익성을 확보하지 못하는 핵심 요인이 되고 있다.

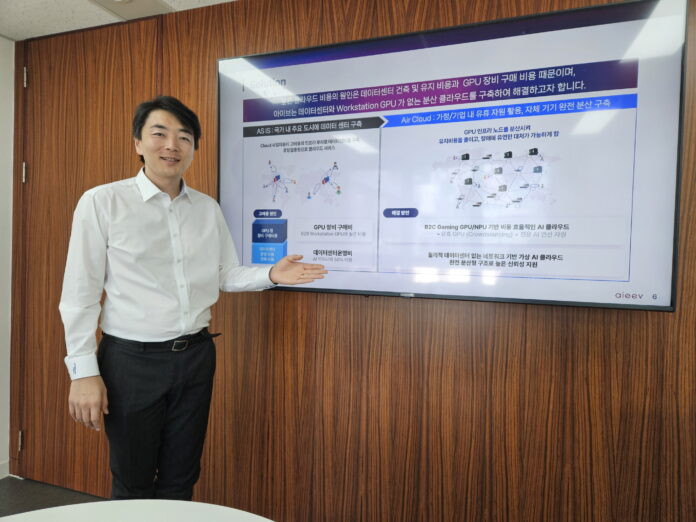

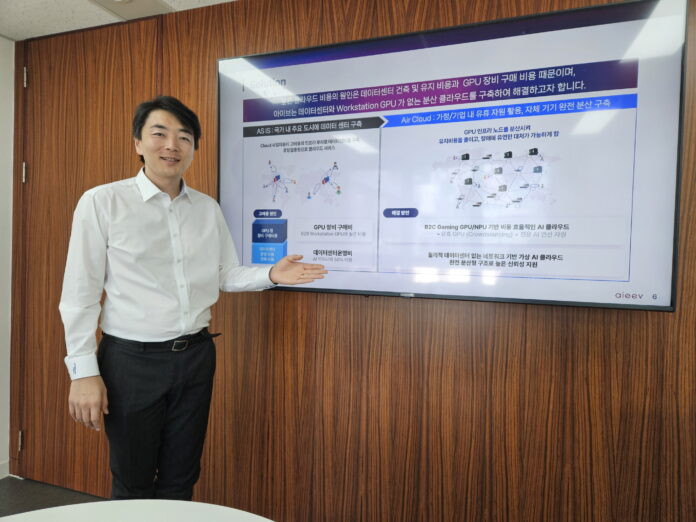

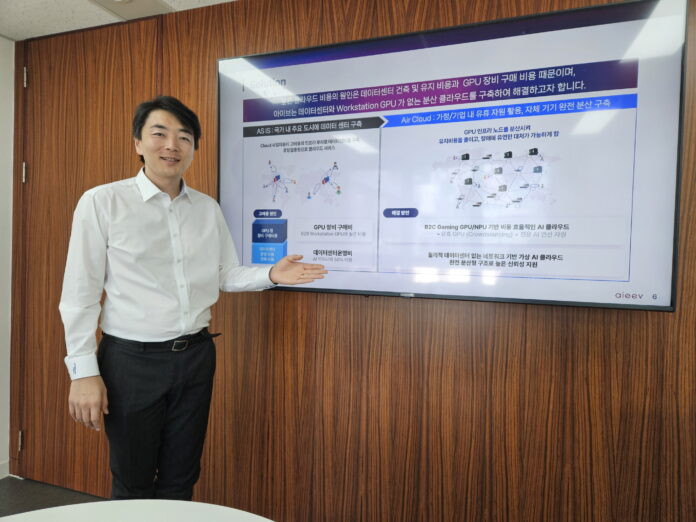

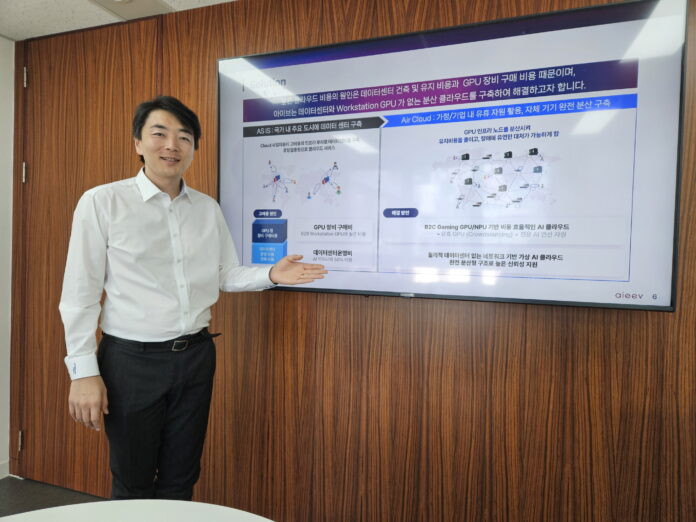

AI를 서비스하는 기업에게 인프라 비용을 낮춰주는 기업이 있다. 모델 개발에는 고사양 GPU가 필요하지만, 추론은 완성된 모델에서 정해진 작업만 반복하기 때문에 저사양 GPU로도 충분하다. 이 점에 주목한 에이아이브(aieev)는 추론에 필요한 GPU 자원을 가정이나 PC방 등 유휴 PC들을 연결한 분산형 가상 클라우드 인프라로 구축해 GPU 비용을 획기적으로 낮췄다.

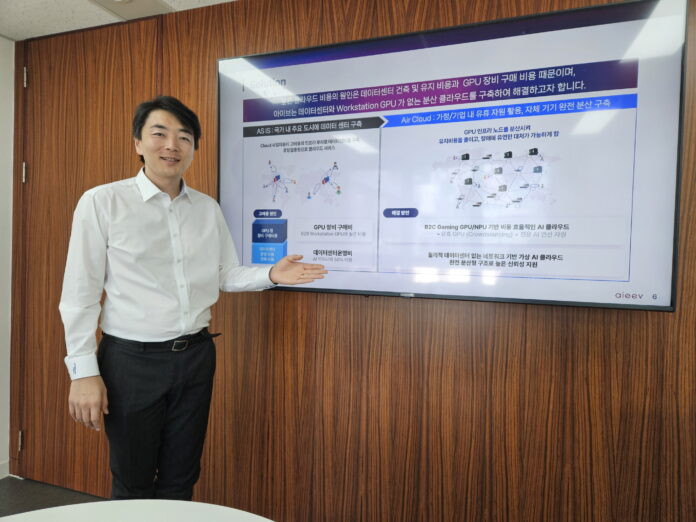

에이아이브의 박세진 대표는 “대형언어모델을 개발하는 데는 GPU 수천, 수만 장이 필요하지만, 추론 서비스는 몇 장으로도 충분합니다. AI 인프라 구축 비용을 낮추면 많은 사람들이 더 많은 AI 서비스를 이용할 수 있습니다”라고 설명했다.

박 대표는 코인 마이닝으로 많은 GPU가 사용되면서 AI 서비스 기업들이 GPU 부족으로 고통받고 있다는 사실을 발견하고 2024년 초 에이아이브를 설립했다.

박 대표는 포스텍에서 시스템 소프트웨어로 박사학위를 취득했으며, 현재 계명대학교 컴퓨터공학과 겸임 교수로 재직 중이다. 에이아이브 팀은 포스텍, 카이스트, 고려대 출신의 시스템 소프트웨어 전공자들로 구성돼 있으며, 대부분 15년 이상의 업계 경력을 갖고 있다.

에이아이브는 설립 후 10개의 특허를 출원했으며, 현재 2개의 상용 고객을 확보했고 10개 기업과 PoC를 진행 중이다. 지난 8월에는 SK텔레콤의 ‘AI Startup Accelerator 3기’ 프로그램에 선정되기도 했다. 기술 상용화를 위해 2026년 상반기 시리즈 A 투자를 추진할 계획이다.

에이아이브 강남 소재 사무실에서 만난 박세진 대표로부터 유휴 GPU를 연결하는 방식, 분산된 GPU의 안정적 운영 방법, 그리고 AI 인프라 비용 절감을 추구하는 에이아이브의 비전에 대해 이야기를 들었다.

전 세계 개인용 PC를 연결하다

그렇다면 유휴 GPU를 어떻게 연결할까?

일반적으로 개인 PC나 PC방의 컴퓨터는 공개 IP 주소를 가지지 않아 외부 접속이 불가능하다. 외부 접속이 불가능한 PC를 어떻게 연결할 수 있을까?

에이아이브는 NAT Traversal 기술을 통해 개인 PC와 연결한다. 연결하고자 하는 개인 PC가 에이아이브 서버에 연결을 요청하게 되면, 공유기가 자동으로 통로를 열어주고, 에이아이브는 이 통로를 통해 PC의 GPU를 제어할 수 있다. 만약 이 방법이 작동하지 않으면, 중간 서버(Relay Server)를 거쳐 연결한다. 에이아이브는 기술 테스트 결과 십만 대 이상의 노드를 연결하는 테스트를 마쳤다.

데이터센터가 필요없다는 점은 가격 경쟁력으로 직결된다. 전통적인 데이터센터에서는 전력비의 50%가 냉각에 들어간다. 많은 장비가 좁은 공간에 집적되어 있기 때문에 엄청난 발열이 발생한다.

“데이터센터 건물을 짓고, 운영하고, 관리하는 인력만 해도 상당히 많습니다. 에이아이브는 보안, 운영, 유지보수 등에 필요한 담당자를 둘 필요가 없습니다.”

연결되었다고 해서 끝나는 게 아니다. 대규모 네트워크를 관리하기 위해서는 각 노드 간의 효율적인 통신과 장애 격리가 필요하다.

“많은 노드를 관리하려면 단순한 네트워크 연결만으로는 부족합니다. 각 노드의 상태를 효율적으로 모니터링하고, 만약 어떤 노드에 장애가 나면 그 작업을 다른 노드로 빠르게 이전해야 합니다.”

안정적인 운영과 자동 할당 기술로 비용 절감

분산 시스템에 있어 중요한 것은 서비스 안정성이다.

AI 서비스를 운영하려면 수많은 오픈소스 라이브러리가 필요한데, 이 중 하나라도 빠지거나 버전이 맞지 않으면 서비스가 제대로 작동하지 않는다. 에이아이브는 이 문제를 해결하기 위해 컨테이너 기술을 개발했다. 컨테이너 기술을 통해 AI 모델 구동에 필요한 모든 오픈소스 라이브러리, 시스템 설정, 의존성 등을 하나의 패키지로 묶어 제공함으로써, 어디서든 동일한 환경에서 안정적으로 모델을 실행할 수 있다.

대형 클라우드 서비스나 데이터센터는 모든 서비스가 한 곳에 집중되어 있다. 그래서 만약 데이터센터의 네트워크에 문제가 생기거나 전력 공급에 이상이 생기면 전체 서비스가 중단되는 사태가 발생한다. 그렇기 때문에 하나의 서버에 장애가 발생해도 서비스가 중단되지 않도록 이중화를 구성해야 하며, 자동 복구 시스템을 갖춰야 한다.

에이아이브는 이 과정 전체를 완전 자동화했다. 에이아이브 플랫폼에 모델만 올리면 그 이후의 모든 AI 서비스화 과정 즉 성능 모니터링, 이중화 구성, 자동 복구 등이 모두 자동으로 처리된다. 한 노드에 문제가 발생해도 내부 스케줄러가 다른 노드로 그 작업을 즉시 전환하기 때문에 사용자 입장에서는 논리적으로 장애를 느끼지 못한다.

“한 노드에서 장애가 발생해도, 내부 스케줄러에 의해 그 작업이 바로 다른 노드에서 자동으로 스위칭되서 수행됩니다. 사용자 입장에서는 물리적으로는 장애가 났지만, 논리적으로는 그 장애를 느끼지 못합니다.”

이와 함께 중요한 기능이 오토스케일링(Auto Scaling)이다. 일반적인 클라우드에서는 예상되는 트래픽에 맞춰 미리 서버를 준비해야 한다. 문제는 고객이 얼마나 몰릴지 예측이 불가능하다는 데에 있다. 그래서 보수적으로 자원을 미리 확보해둔다. 비용이 많이 들더라도 서비스 중단이 더 나쁘기 때문이다.

사용량에 따라 자원을 효율적으로 분배한다면 그만큼 비용이 절감될 수 있다. 에이아이브는 이 문제를 오토스케일링으로 해결한다. 트래픽이 증가하면 필요한 노드와 컨테이너가 자동으로 확장되고, 트래픽이 줄어들면 자동으로 축소된다. 손님이 몰리면 직원을 더 배치하고, 한가할 때는 줄이는 것처럼 트래픽에 맞춰 자원을 자동으로 늘렸다 줄었다 할 수 있다. 그만큼 비용을 절약할 수 있게 되는 것이다. 사용자는 민감도를 조정해서 확장 속도를 제어할 수 있다.

“기업이 원하는 정도에 따라 자동 확장 속도를 조절할 수 있습니다. 한 고객사의 경우, 이 오토스케일링 기술을 통해 기존 클라우드 대비 약 80%의 비용을 절감할 수 있었습니다.”

에이아이브는 AI 모델의 안정적인 운영, 성능 최적화, 비용 효율화를 모두 담보하는 자동화된 운영 인프라를 제공하고 있다. 스타트업이라도 대기업 수준의 인프라 안정성을 즉시 확보할 수 있다는 의미다.

스타트업부터 대기업까지

에이아이브는 현재 전국 PC방을 관리하는 업체와 협력해 파일럿 테스트를 진행하고 있다. 테스트가 완료되면 전국 약 4,000개의 PC방에 분산된 유휴 GPU를 활용해 AI 서비스 기업에 컴퓨팅 자원을 공급할 수 있게 된다. 기업과도 협력 논의가 활발하다. 특히 소규모 AI 자원이 필요한 기업들의 수요가 점차 증가하고 있어, 이들이 에이아이브의 주요 타깃 고객이 될 예정이다.

- 저비용 추론 클라우드 ‘Air Cloud’ & ‘Air Container’

에이아이브의 ‘Air Cloud’는 AWS를 대체할 수 있는 저비용 AI 추론 플랫폼이다. 고객의 필요에 따라 두 가지 옵션으로 제공된다.

Air Cloud Standard는 개인용 PC와 PC방의 유휴 GPU를 크라우드소싱하는 방식으로 운영된다. 경제성을 최우선으로 하기 때문에 스타트업과 개발자들이 최소한의 비용으로 AI 모델을 테스트하고 배포할 수 있다. Air Cloud Plus는 엔터프라이즈급 안정성과 성능을 필요로 하는 기업을 위해 설계됐다. 검증된 커스텀 빌드 노드로 구성된 분산 클러스터이며, 99.99% 가용성을 보장해 미션 크리티컬한 AI 서비스도 안정적으로 운영할 수 있다.

고객은 트래픽에 맞춰 필요한 만큼의 GPU를 유동적으로 할당받으며, 사용한 시간만큼 과금된다. 이는 예측 불가능한 트래픽 변화에 유연하게 대응할 수 있다는 의미다. 또한 에이아이브의 대시보드를 통해 API 엔드포인트의 성능과 상태를 실시간으로 모니터링하고, 상세한 로그를 분석할 수 있다. 이를 통해 고객은 자신의 AI 서비스가 제대로 작동하는지 언제든지 확인하고, 필요시 빠르게 문제에 대응할 수 있다.

- OpenAI 호환 AI API 서비스 ‘Air API’

‘Air API’는 개발사들이 자신의 서비스에 즉시 통합할 수 있는 생성형 AI 인터페이스다. 복잡한 AI 모델 구축 없이 API 호출만으로 ChatGPT 같은 AI 기능을 구현할 수 있다.

Air API는 콜(호출)당 과금하는 방식으로, 기업이 실제 사용한 만큼만 비용을 지불하면 된다. Air API는 완전한 서버리스 AI 솔루션이다. 고객은 인프라 관리나 서버 운영 걱정 없이 오직 비즈니스 로직에만 집중할 수 있다. 트래픽이 증가하면 자동으로 스케일되고, 감소하면 자동으로 축소돤다.

Air API는 2026년 정식 서비스 론칭을 목표로 하고 있다. 론칭 이후 한국어 LLM 기반의 다양한 모델을 지원할 예정이다.

- 기업의 유휴 GPU 최적화 ‘Private Air Cloud’

Private Air Cloud는 대기업 내 산재된 GPU 자원을 하나의 통합 플랫폼으로 운영하는 솔루션이다. 각 부서나 팀이 필요에 따라 GPU를 확보하다 보니 전사 차원의 효율적인 운영이 어렵다. Private Air Cloud는 이 문제를 근본적으로 해결한다. 마치 Air Cloud가 전 세계의 분산된 GPU를 모으는 것처럼, Private Air Cloud는 기업 내부의 분산된 GPU를 실시간으로 통합 관리하고, 필요한 부서에 동적으로 할당할 수 있다.

“모든 사람의 AI“

에이아이브는 AI Equality, Everyone’s Value의 영문 약자에서 이름을 따왔다. AI 평등, 모두의 가치라는 의미를 담고 있다.

“정보 격차는 앞으로 계속 벌어질 거라고 생각합니다. 정보 접근성의 격차는 눈에 보이지 않지만 심화될 것입니다. 지금도 무료로 ChatGPT를 쓰는 사람이 있는 반면 월 30만 원씩 내고 ChatGPT Plus를 쓰는 사람도 있습니다. 이 두 사람의 정보 접근성은 큰 차이가 납니다.”

박 대표의 우려는 현실이 되고 있다. AI 서비스가 모든 산업으로 확대되면서, AI에 접근 가능한 기업과 그렇지 못한 기업의 격차는 점점 벌어지고 있다.

“이런 격차는 없어야 한다고 생각해요. AI의 혜택은 누구라도 누릴 수 있어야 합니다. 에이아이브는 모든 사람들이 부담 없이 AI를 쓸 수 있는 세상을 만들려고 합니다. 그러려면 인프라 비용이 낮아져야 합니다.”

에이아이브는 단순한 저비용 서비스를 만드는 것을 넘어, 기술을 통해 사회의 격차를 줄이려는 노력을 시도하고 있다. 그것이 가능하려면 인프라의 혁신이 필수다. 에이아이브의 도전이 성공한다면, 몇 년 뒤 AI의 이용 구도는 지금과 완전히 달라져 있을 것이다.

Connecting idle GPUs to reduce AI infrastructure costs: Aieev, a distributed cloud startup specializing in distributed cloud computing, is taking on the challenge.

Connect idle PCs with NAT Traversal and automatically allocate resources with autoscaling to reduce costs.

-Providing automated operational infrastructure for stable operation, performance optimization, and cost efficiency of AI models.

After completing pilot testing, the service will officially launch next year, and Series A investment is expected in the first half of 2026.

The core of AI service implementation is training and inference. While training is the process of training an AI model to recognize patterns and identify correlations in large-scale data, inference is the process by which the trained model generates answers to user questions and the actual operation of the service.

Developing AI services requires massive data sets and high-performance computing. Data centers must be equipped with thousands or even tens of thousands of GPUs and a high-bandwidth network to optimize inter-GPU communication. GPUs cost over 15 million won per unit, sometimes exceeding 20 million won. These enormous infrastructure costs, particularly the high cost of purchasing and operating GPUs, are a key factor preventing most companies providing AI services from achieving profitability.

There's a company that lowers infrastructure costs for companies providing AI services. While model development requires high-end GPUs, inference relies on repeating only predefined tasks from a completed model, so even low-end GPUs are sufficient. Recognizing this, aieev (aieev) dramatically reduced GPU costs by building a distributed virtual cloud infrastructure that connects idle PCs in homes and PC cafes to provide the GPU resources needed for inference.

Park Se-jin, CEO of aieev, explained, "Developing large language models requires thousands or tens of thousands of GPUs, but inference services require just a few. Lowering the cost of building AI infrastructure will enable more people to access more AI services."

CEO Park founded aieev in early 2024 after discovering that AI service companies were suffering from a GPU shortage due to the large use of GPUs for coin mining.

CEO Park earned his Ph.D. in systems software from POSTECH and currently serves as an adjunct professor in the Department of Computer Science and Engineering at Keimyung University. The aieev team consists of system software specialists from POSTECH, KAIST, and Korea University, most of whom have over 15 years of industry experience.

Since its founding, aieev has filed for ten patents, secured two commercial customers, and is currently conducting proof-of-concept (PoC) trials with ten companies. Last August, it was selected for SK Telecom's "AI Startup Accelerator 3rd Batch." To commercialize its technology, the company plans to pursue a Series A investment in the first half of 2026.

We met with CEO Park Se-jin at aieev's Gangnam office to learn about how idle GPUs are connected, how distributed GPUs operate stably, and aieev's vision for reducing AI infrastructure costs.

Connecting personal computers around the world

So how do we connect the idle GPU?

Typically, personal computers or computers in PC cafes don't have public IP addresses, making them inaccessible to outsiders. How can you connect to a PC that's inaccessible?

aieev connects to a personal computer via NAT traversal technology. When the desired personal computer requests a connection to the aieev server, the router automatically opens a connection, allowing aieev to control the PC's GPU. If this method fails, the connection is made via an intermediate server (relay server). Aieev has completed technical testing, connecting over 100,000 nodes.

Eliminating the need for a data center directly translates into cost competitiveness. In traditional data centers, 50% of electricity costs go to cooling. Because so much equipment is packed into such a small space, it generates enormous amounts of heat.

"The staff needed to build, operate, and maintain data centers alone is quite large. Aieev eliminates the need for dedicated staff for security, operations, and maintenance."

Connectivity isn't the end of the story. Managing a large-scale network requires efficient communication and fault isolation between each node.

"Managing numerous nodes requires more than just a simple network connection. Efficient monitoring of the status of each node is essential, and if a node fails, the workload must be quickly transferred to another node."

Cost savings through stable operation and automatic allocation technology.

What is important in a distributed system is service stability.

Operating AI services requires numerous open source libraries, and if any of them are missing or have incompatible versions, the service will not function properly. To address this issue, aieev developed container technology. Container technology bundles all the open source libraries, system settings, and dependencies required to run AI models into a single package, enabling stable model execution in a consistent environment, anywhere.

Large cloud services and data centers centralize all services in one location. Therefore, if a network issue or power outage occurs in the data center, the entire service can be disrupted. Therefore, redundancy must be configured and an automatic recovery system must be in place to prevent service interruption even if a single server fails.

Aieev fully automates this entire process. Simply upload a model to the Aieev platform, and all subsequent AI service-oriented processes, including performance monitoring, redundancy configuration, and automatic recovery, are handled automatically. Even if a problem occurs on one node, the internal scheduler immediately switches the workload to another node, so users don't perceive any logical disruption.

Even if a failure occurs on one node, the internal scheduler automatically switches the task to another node and executes it. From the user's perspective, there's a physical failure, but logically, the failure is undetectable.

Another important feature is autoscaling. In typical cloud environments, servers must be provisioned in advance to meet anticipated traffic. The problem lies in the impossibility of predicting the volume of users. Therefore, resources are conservatively secured in advance. Even if it costs more, service interruption is far more detrimental.

Efficiently allocating resources based on usage can lead to significant cost savings. aieev solves this problem with autoscaling. As traffic increases, the required nodes and containers are automatically scaled up, and as traffic decreases, they are automatically scaled down. Just as more staff are deployed during peak customer activity and fewer during slow periods, resources can be automatically scaled up and down based on traffic. This translates into significant cost savings. Users can adjust the sensitivity to control the scaling rate.

"You can adjust the automatic scaling rate based on your business needs. For one customer, this autoscaling technology enabled cost savings of approximately 80% compared to traditional cloud services."

aieev provides an automated operational infrastructure that ensures stable operation, performance optimization, and cost efficiency for AI models. This means even startups can immediately achieve infrastructure stability comparable to that of large enterprises.

From startups to large corporations

aieev is currently conducting a pilot test in collaboration with a company that manages PC cafes nationwide. Upon completion, the company will be able to utilize idle GPUs distributed across approximately 4,000 PC cafes nationwide to provide computing resources to AI service companies. Discussions with companies are also active. In particular, demand from companies requiring small-scale AI resources is steadily increasing, and these companies are expected to become aieev's primary target customers.

- Low-cost inference clouds: Air Cloud and Air Container

aieev's 'Air Cloud' is a low-cost AI inference platform that can replace AWS. It is offered in two options to suit customer needs.

Air Cloud Standard operates by crowdsourcing idle GPUs from personal PCs and PC cafes. Prioritizing cost-effectiveness, it allows startups and developers to test and deploy AI models at minimal cost. Air Cloud Plus is designed for businesses requiring enterprise-grade stability and performance. It is a distributed cluster comprised of proven, custom-built nodes and guarantees 99.99% availability, ensuring the stable operation of even mission-critical AI services.

Customers are dynamically allocated the number of GPUs they need based on their traffic and are billed based on the time they use. This allows them to flexibly respond to unpredictable traffic fluctuations. Furthermore, aieev's dashboard allows them to monitor the performance and status of API endpoints in real time and analyze detailed logs. This allows customers to verify that their AI services are functioning properly at any time and quickly respond to issues when necessary.

- OpenAI-compatible AI API service 'Air API'

'Air API' is a generative AI interface that developers can immediately integrate into their services. AI functions like ChatGPT can be implemented simply by calling the API, without building complex AI models.

Air API is billed per call, allowing businesses to pay only for what they actually use. Air API is a completely serverless AI solution, allowing customers to focus solely on business logic without worrying about infrastructure management or server operations. It automatically scales as traffic increases and scales back as it decreases.

Air API aims to officially launch in 2026. After launch, it plans to support various Korean LLM-based models.

- Private Air Cloud: Optimizing Idle GPUs for Enterprises

Private Air Cloud is a solution that manages GPU resources scattered across large corporations as a single, integrated platform. Since each department or team acquires GPUs based on their needs, efficient company-wide operations are difficult. Private Air Cloud fundamentally solves this problem. Just as Air Cloud aggregates GPUs distributed around the world, Private Air Cloud can manage distributed GPUs within a company in real time and dynamically allocate them to the departments that need them.

AI for everyone

The name aieev is an acronym for AI Equality, Everyone's Value. It embodies the meaning of AI equality and everyone's value.

"I believe the information gap will continue to widen. The gap in information accessibility, though invisible, will deepen. Some people use ChatGPT for free, while others pay 300,000 won per month for ChatGPT Plus. There's a significant difference in the information accessibility between these two."

Park's concerns are becoming reality. As AI services expand across all industries, the gap between companies with access to AI and those without is widening.

"I believe this gap should disappear. Everyone should be able to enjoy the benefits of AI. aieev aims to create a world where everyone can use AI without burden. To achieve this, infrastructure costs must decrease."

Beyond simply creating low-cost services, aieev is attempting to bridge the gap in society through technology. To achieve this, infrastructure innovation is essential. If aieev's challenge is successful, the landscape of AI usage will be radically transformed in a few years.

アイドルGPU接続してAIインフラストラクチャコストを削減、分散クラウド専門スタートアップaieevの挑戦

-NAT TraversalでアイドルPC接続…オートスケーリングでリソースを自動割り当てしてコストを下げる

-AIモデルの安定した運用、パフォーマンスの最適化、コスト効率化のための自動化された運用インフラストラクチャ

-パイロットテスト終了後、来年にサービス正式ローンチ… 2026年上半期シリーズA投資誘致推進

AIサービスの実装の鍵は、学習(Training)と推論(Inference)です。学習がAIモデルが大規模データからパターンを認識し、関連性を把握するようにモデルを訓練するプロセスである場合、推論は学習されたモデルがユーザーの質問に答えを生成し、実際にサービスが運営されるプロセスである。

AIサービスを行うには、大規模なデータセットと高性能コンピューティングが不可欠です。数千から数万のGPUを配置し、GPU間の通信を最適化するための高帯域幅ネットワークを備えたデータセンターを運営する必要があります。 GPUは1台あたり1,500万ウォン以上で、2,000万ウォンを超えることもある。このように膨大なインフラコスト、特に高価なGPU購入と運営コストがAIをサービスするほとんどの企業が収益性を確保できない核心要因となっている。

AIをサービスする企業にインフラコストを下げる企業がある。モデル開発には高仕様GPUが必要だが、推論は完成したモデルで定められた作業だけ繰り返すため、低仕様GPUでも十分だ。この点に注目したaieev(aieev)は、推論に必要なGPUリソースを家庭やPCルームなどアイドルPCを接続した分散型仮想クラウドインフラとして構築し、GPUコストを画期的に下げた。

Aieevのパク・セジン代表は「大型言語モデルを開発するにはGPU数千、数万枚が必要だが、推論サービスは数枚でも十分です。AIインフラ構築コストを下げれば多くの人がより多くのAIサービスを利用できる」と説明した。

朴代表はコインマイニングで多くのGPUが使用され、AIサービス企業がGPU不足に苦しんでいることを発見し、2024年初めにaieevを設立した。

朴代表はポステックでシステムソフトウェアで博士学位を取得しており、現在戒明大学コンピュータ工学と兼任教授として在職中だ。 aieevチームはフォステック、カイスト、高麗大学出身のシステムソフトウェア専攻者で構成されており、ほとんど15年以上の業界キャリアを持っている。

aieevは設立後10の特許を出願し、現在2つの商用顧客を確保し、10の企業とPoCを進めている。去る8月にはSKテレコムの「AI Startup Accelerator 3期」プログラムに選定された。技術商用化のために2026年上半期シリーズA投資を推進する計画だ。

aieev江南(カンナム)のオフィスで会ったパク・セジン代表からアイドルGPUをつなぐ方法、分散GPUの安定的な運用方法、そしてAIインフラのコスト削減を追求するaieevのビジョンについて話を聞いた。

世界中のパーソナルPCを接続する

それでは、アイドルGPUをどのように接続しますか?

一般的に個人PCやPCルームのコンピュータは公開IPアドレスを持たず、外部接続ができない。外部接続ができないPCをどのように接続できますか?

aieevはNAT Traversalの技術によって個人的なPCと接続する。接続したいパーソナルPCがaieevサーバーに接続を要求すると、ルーターは自動的に通路を開き、aieevはこの通路を介してPCのGPUを制御できます。この方法が機能しない場合は、中間サーバー(Relay Server)を介して接続します。 aieevは技術テストの結果、10万台以上のノードを接続するテストを終えました。

データセンターが必要ないという点は価格競争力に直結する。伝統的なデータセンターでは、電力比の50%が冷却に入ります。多くの機器が狭い空間に集積されているため、膨大な発熱が発生します。

「データセンターの建物を建て、運営し、管理する人材だけでもかなり多いです。aieevはセキュリティ、運営、メンテナンスなどに必要な担当者を置く必要はありません。」

つながったからといって終わるわけではない。大規模ネットワークを管理するには、各ノード間の効率的な通信と障害の分離が必要です。

「多くのノードを管理するには、単純なネットワーク接続だけでは不十分です。各ノードの状態を効率的に監視し、あるノードに障害が発生した場合は、そのタスクを別のノードにすばやく移行する必要があります。」

安定した運用と自動配分技術によるコスト削減

分散システムにとって重要なのはサービスの安定性です。

AIサービスを運営するには数多くのオープンソースライブラリが必要ですが、これらのいずれかが欠けたりバージョンが合わないとサービスが正常に動作しない。 aieevはこの問題を解決するためにコンテナ技術を開発しました。コンテナ技術により、AIモデルの駆動に必要なすべてのオープンソースライブラリ、システム設定、依存性などを1つのパッケージにまとめて提供することで、どこでも同じ環境で安定してモデルを実行することができる。

大型クラウドサービスやデータセンターは、すべてのサービスが一箇所に集中している。そのため、データセンターのネットワークに問題が発生したり、電力供給に異常が生じた場合、サービス全体が中断される事態が発生する。そのため、1台のサーバーに障害が発生してもサービスが中断されないように冗長化を構成し、自動回復システムを備える必要があります。

aieevはこのプロセス全体を完全に自動化した。 aieevプラットフォームにモデルだけを載せれば、それ以降のすべてのAIサービス化過程、すなわち性能監視、二重化構成、自動復旧などがすべて自動的に処理される。あるノードに問題が発生しても、内部スケジューラが別のノードにそのジョブを直ちに切り替えるため、ユーザの立場では論理的に障害を感じることができない。

「あるノードで障害が発生しても、内部スケジューラによってそのタスクがすぐに別のノードで自動的に切り替えられます。ユーザーの立場では物理的には障害が発生しましたが、論理的にはその障害を感じません。」

これと共に重要な機能がオートスケーリング(Auto Scaling)だ。一般的なクラウドでは、予想されるトラフィックに合わせて事前にサーバーを準備する必要があります。問題は顧客がどれだけ追い込まれるか予測できないということにある。それで保守的に資源をあらかじめ確保しておく。費用がかかるにもかかわらず、サービスの中断が悪いからだ。

使用量に応じてリソースを効率的に分配すれば、それだけコストを削減できる。 aieevはこの問題をオートスケーリングで解決します。トラフィックが増加すると、必要なノードとコンテナが自動的に拡張され、トラフィックが減少すると自動的に縮小されます。ゲストが集まったらスタッフをさらに配置し、暇なときは減らすようにトラフィックに合わせてリソースを自動的に増やして減ったということができる。それだけ費用を節約できるようになるのだ。ユーザーは感度を調整して拡張速度を制御できます。

「企業が望む程度に応じて自動拡張速度を調整することができます。ある顧客の場合、このオートスケーリング技術により、既存のクラウドに比べ約80%のコストを削減できました。」

aieevは、AIモデルの信頼性の高い運用、パフォーマンスの最適化、コスト効率化の両方を担保する自動化された運用インフラストラクチャを提供しています。スタートアップでも大企業レベルのインフラの安定性をすぐに確保できるという意味だ。

スタートアップから大企業まで

aieevは現在、全国のPCルームを管理する企業と協力してパイロットテストを進めている。テストが完了すると、全国約4,000個のPCルームに分散されたアイドルGPUを活用してAIサービス企業にコンピューティングリソースを供給できるようになる。企業とも協力議論が活発だ。特に小規模AI資源が必要な企業の需要が徐々に増加しており、これらがaieevの主要ターゲット顧客になる予定だ。

- 低コスト推論クラウド 'Air Cloud' & 'Air Container'

aieevの「Air Cloud」は、AWSに代わる低コストAI推論プラットフォームです。顧客のニーズに応じて2つのオプションがあります。

Air Cloud Standardは、パーソナルPCとPCルームのアイドルGPUをクラウドソーシングする方式で運営される。経済性を最優先にするため、スタートアップと開発者が最小限のコストでAIモデルをテストして配布することができる。 Air Cloud Plusは、エンタープライズクラスの安定性とパフォーマンスを必要とする企業向けに設計されています。検証済みのカスタムビルドノードで構成された分散クラスタであり、99.99%の可用性を保証し、ミッションクリティカルなAIサービスも安定的に運営できる。

顧客はトラフィックに合わせて必要なだけのGPUを流動的に割り当てられ、使用した時間だけ課金されます。これは、予測不可能なトラフィックの変化に柔軟に対応できることを意味します。また、aieevのダッシュボードを使用して、APIエンドポイントのパフォーマンスと状態をリアルタイムで監視し、詳細なログを分析できます。これにより、顧客は自分のAIサービスが正しく機能していることをいつでも確認し、必要に応じて迅速に問題に対応することができます。

- OpenAI互換AI APIサービス「Air API」

「Air API」は、開発者が自分のサービスに即座に統合できる生成型AIインターフェースだ。複雑なAIモデルを構築することなく、API呼び出しだけでChatGPTなどのAI機能を実装できます。

Air APIは、コール(コール)ごとに課金する方法で、企業が実際に使用した分だけ費用を支払えばよい。 Air APIは完全なサーバーレスAIソリューションです。顧客は、インフラストラクチャ管理やサーバーの運営を心配することなく、ビジネスロジックだけに集中できます。トラフィックが増加すると自動的にスケールされ、減少すると自動的に縮小されます。

Air APIは2026年の正式サービスのローンチを目指している。ローンチ後、韓国語LLMベースの多様なモデルをサポートする予定だ。

- 企業のアイドルGPU最適化「Private Air Cloud」

Private Air Cloudは、大企業内に散在したGPUリソースを単一の統合プラットフォームとして運営するソリューションです。各部署やチームが必要に応じてGPUを確保しているため、戦士レベルの効率的な運営が難しい。 Private Air Cloudはこの問題を根本的に解決します。 Air Cloudが世界中の分散GPUを集めるように、Private Air Cloudは企業内の分散GPUをリアルタイムで統合管理し、必要な部門に動的に割り当てることができます。

「すべての人のAI」

aieevはAI Equality、Everyone's Valueの英語の略語から名前を取った。 AI平等、皆の価値という意味を込めている。

「情報ギャップは今後も引き続き広がると思います。情報アクセシビリティのギャップは目に見えないが深刻になるでしょう。今でも無料でChatGPTを使う人がいる一方、月30万ウォンずつ出してChatGPT Plusを使う人もいます。

朴代表の懸念は現実になっている。 AIサービスがすべての産業に拡大し、AIにアクセス可能な企業とそうでない企業の格差はますます広がっている。

「このようなギャップはあってはならないと思います。AIの恩恵は誰でも享受できなければなりません。aieevは、誰もが気軽にAIを書くことができる世界を作ろうとしています。

aieevは単純な低コストサービスを作ることを越えて、技術を通じて社会の格差を減らそうとする努力を試みている。それを可能にするには、インフラの革新が不可欠です。 aieevの挑戦が成功すれば、数年後にAIの利用構図は今と完全に変わっているだろう。

连接闲置的 GPU 以降低 AI 基础设施成本:专注于分布式云计算的分布式云初创公司 Aieev 正在迎接这一挑战。

利用 NAT 穿越连接空闲 PC,并利用自动扩展功能自动分配资源,从而降低成本。

-为人工智能模型的稳定运行、性能优化和成本效益提供自动化运行基础设施。

试点测试完成后,该服务将于明年正式推出,A 轮融资预计将于 2026 年上半年进行。

人工智能服务实现的核心是训练和推理。训练是指训练人工智能模型以识别大规模数据中的模式和关联性的过程,而推理是指训练好的模型生成用户问题的答案以及实际运行服务的过程。

开发人工智能服务需要海量数据集和高性能计算。数据中心必须配备数千甚至数万个GPU以及高带宽网络,以优化GPU间的通信。每个GPU的成本超过1500万韩元,有时甚至超过2000万韩元。这些巨额基础设施成本,尤其是GPU的高昂购置和运营成本,是阻碍大多数人工智能服务提供商实现盈利的关键因素。

有一家公司致力于降低人工智能服务提供商的基础设施成本。虽然模型开发需要高端GPU,但推理仅依赖于重复执行已完成模型中预定义的任务,因此即使是低端GPU也足以胜任。基于此,aieev通过构建分布式虚拟云基础设施,将家庭和网吧中闲置的PC连接起来,提供推理所需的GPU资源,从而大幅降低了GPU成本。

aieev首席执行官朴世镇解释说:“开发大型语言模型需要成千上万个GPU,但推理服务只需要几个。降低构建人工智能基础设施的成本将使更多人能够获得更多的人工智能服务。”

CEO Park 在 2024 年初创立了 aieev,当时他发现由于大量 GPU 用于加密货币挖矿,人工智能服务公司正面临 GPU 短缺的问题。

朴社长在浦项科技大学获得系统软件博士学位,目前担任启明大学计算机科学与工程系兼职教授。aieev团队由来自浦项科技大学、韩国科学技术院和高丽大学的系统软件专家组成,其中大多数人拥有超过15年的行业经验。

自成立以来,aieev 已申请了十项专利,获得了两家商业客户,目前正在与十家公司进行概念验证 (PoC) 试验。去年八月,该公司入选 SK Telecom 的“人工智能创业加速器第三期”。为了实现技术商业化,该公司计划在 2026 年上半年进行 A 轮融资。

我们在 aieev 位于江南的办公室与 CEO 朴世镇会面,了解了闲置 GPU 的连接方式、分布式 GPU 的稳定运行方式,以及 aieev 在降低 AI 基础设施成本方面的愿景。

连接世界各地的个人电脑

那么,我们如何连接空闲的GPU呢?

通常情况下,个人电脑或网吧的电脑没有公网IP地址,外人无法访问。那么,如何连接到一台无法访问的电脑呢?

aieev 通过 NAT 穿透技术连接到个人电脑。当目标个人电脑请求连接到 aieev 服务器时,路由器会自动建立连接,从而允许 aieev 控制该电脑的 GPU。如果此方法失败,则会通过中间服务器(中继服务器)建立连接。aieev 已完成技术测试,连接了超过 10 万个节点。

无需建设数据中心就能直接降低成本。在传统数据中心,50% 的电力成本都用于冷却。由于大量设备被塞进狭小的空间,会产生大量的热量。

“仅数据中心的建设、运营和维护就需要相当多的人员。Aieev 消除了对专门负责安全、运营和维护人员的需求。”

连接性并非故事的全部。管理大型网络还需要各节点之间高效的通信和故障隔离。

“管理众多节点需要的不仅仅是简单的网络连接。对每个节点的状态进行高效监控至关重要,如果某个节点发生故障,必须迅速将工作负载转移到另一个节点。”

通过稳定运行和自动分配技术实现成本节约。

分布式系统中最重要的是服务稳定性。

运行人工智能服务需要大量的开源库,如果缺少任何库或库版本不兼容,服务将无法正常运行。为了解决这个问题,aieev 开发了容器技术。容器技术将运行人工智能模型所需的所有开源库、系统设置和依赖项打包到一个单独的软件包中,从而能够在一致的环境中随时随地稳定地执行模型。

大型云服务和数据中心将所有服务集中在一个位置。因此,如果数据中心发生网络问题或断电,整个服务都可能中断。所以,必须配置冗余机制,并部署自动恢复系统,以防止即使单个服务器发生故障也导致服务中断。

Aieev 完全自动化了整个流程。只需将模型上传到 Aieev 平台,所有后续的 AI 服务相关流程,包括性能监控、冗余配置和自动恢复,都将自动完成。即使某个节点出现问题,内部调度器也会立即将工作负载切换到另一个节点,因此用户不会感受到任何逻辑中断。

即使某个节点发生故障,内部调度器也会自动将任务切换到另一个节点并执行。从用户的角度来看,这表现为物理故障,但从逻辑上讲,这种故障是无法检测到的。

另一个重要特性是自动扩缩容。在典型的云环境中,服务器必须预先配置以满足预期流量。问题在于用户数量无法预测。因此,资源通常会预先进行保守配置。即使成本更高,服务中断的危害也远大于资源不足。

根据使用情况高效分配资源可以显著节省成本。aieev 通过自动扩缩容解决了这个问题。随着流量增加,所需的节点和容器会自动扩容;随着流量减少,则会自动缩容。正如在客户高峰期部署更多员工,在低谷期减少员工一样,资源也可以根据流量自动扩容或缩减。这可以转化为显著的成本节约。用户可以调整灵敏度来控制扩容速率。

“您可以根据业务需求调整自动扩展速率。对于一位客户而言,与传统云服务相比,这项自动扩展技术帮助他们节省了约 80% 的成本。”

aieev 提供自动化运维基础设施,确保 AI 模型稳定运行、性能优化和成本效益。这意味着即使是初创公司也能立即获得与大型企业相媲美的基础设施稳定性。

从初创公司到大型企业

aieev目前正与一家运营全国网吧的公司合作开展试点项目。项目完成后,aieev将能够利用分布在全国约4000家网吧的闲置GPU,为AI服务公司提供计算资源。aieev也正积极与各公司洽谈合作事宜。尤其值得注意的是,对小规模AI资源需求的公司正在稳步增长,预计这些公司将成为aieev的主要目标客户。

- 低成本推理云:空中云和空中集装箱

aieev 的“Air Cloud”是一个低成本的 AI 推理平台,可以替代 AWS。它提供两种选项以满足客户的不同需求。

Air Cloud Standard 通过众包个人电脑和网吧的闲置 GPU 运行。它优先考虑成本效益,使初创公司和开发者能够以最低成本测试和部署 AI 模型。Air Cloud Plus 专为需要企业级稳定性和性能的企业而设计。它是一个由经过验证的定制节点组成的分布式集群,可保证 99.99% 的可用性,从而确保即使是关键任务型 AI 服务也能稳定运行。

系统会根据客户的流量动态分配所需的GPU数量,并按使用时间计费。这使客户能够灵活应对不可预测的流量波动。此外,aieev的控制面板允许客户实时监控API端点的性能和状态,并分析详细的日志。这使得客户可以随时验证其AI服务是否正常运行,并在必要时快速响应问题。

- 兼容OpenAI的AI API服务“Air API”

“Air API”是一个生成式人工智能接口,开发者可以立即将其集成到自己的服务中。诸如ChatGPT之类的AI功能只需调用该API即可实现,无需构建复杂的AI模型。

Air API 按调用次数计费,企业只需为实际使用的资源付费。Air API 是一款完全无服务器的 AI 解决方案,让客户能够专注于业务逻辑,无需担心基础设施管理或服务器运维。它会随着流量的增加自动扩展,并随着流量的减少自动缩减。

Air API 计划于 2026 年正式上线。上线后,计划支持各种基于韩国 LLM 的模型。

- 私有空中云:优化企业闲置GPU

Private Air Cloud 是一款解决方案,它将大型企业分散的 GPU 资源整合到一个统一的平台上进行管理。由于每个部门或团队都根据自身需求获取 GPU,因此难以实现高效的全公司运营。Private Air Cloud 从根本上解决了这个问题。正如 Air Cloud 聚合全球各地的 GPU 一样,Private Air Cloud 可以实时管理公司内部的分布式 GPU,并动态地将其分配给需要的部门。

人人都能用上人工智能

aieev 这个名字是 AI Equality, Everyone's Value(人工智能平等,人人价值)的缩写,它体现了人工智能平等和人人价值的含义。

我认为信息鸿沟会继续扩大。信息获取方面的差距虽然看不见,但却会不断加深。有些人免费使用 ChatGPT,而有些人每月却要支付 30 万韩元购买 ChatGPT Plus。这两者在信息获取方面存在着显著差异。

朴先生的担忧正在成为现实。随着人工智能服务在各行各业的扩展,能够使用人工智能的公司和无法使用人工智能的公司之间的差距正在扩大。

我认为这种差距应该消除。每个人都应该能够享受到人工智能带来的好处。aieev 的目标是创建一个人人都能轻松使用人工智能的世界。为了实现这一目标,基础设施成本必须降低。

除了提供低成本服务之外,aieev 还试图通过技术弥合社会鸿沟。要实现这一目标,基础设施创新至关重要。如果 aieev 的挑战成功,人工智能的应用格局将在几年内发生翻天覆地的变化。

Connecter les GPU inactifs pour réduire les coûts d'infrastructure d'IA : Aieev, une startup spécialisée dans le cloud computing distribué, relève le défi.

Connectez les PC inactifs grâce à la traversée NAT et allouez automatiquement les ressources grâce à la mise à l'échelle automatique afin de réduire les coûts.

-Fourniture d'une infrastructure opérationnelle automatisée pour un fonctionnement stable, une optimisation des performances et une rentabilité des modèles d'IA.

Après la phase de test pilote, le service sera officiellement lancé l'année prochaine, et un investissement de série A est prévu pour le premier semestre 2026.

L'implémentation d'un service d'IA repose essentiellement sur l'entraînement et l'inférence. L'entraînement consiste à entraîner un modèle d'IA à reconnaître des schémas et à identifier des corrélations dans des données à grande échelle, tandis que l'inférence est le processus par lequel le modèle entraîné génère des réponses aux questions des utilisateurs et permet le fonctionnement effectif du service.

Le développement de services d'IA exige des ensembles de données massifs et une puissance de calcul élevée. Les centres de données doivent être équipés de milliers, voire de dizaines de milliers de GPU, et d'un réseau à haut débit pour optimiser la communication entre eux. Le coût unitaire d'un GPU dépasse 15 millions de wons, et peut parfois atteindre 20 millions. Ces coûts d'infrastructure considérables, notamment le coût élevé d'acquisition et d'exploitation des GPU, constituent un obstacle majeur à la rentabilité de la plupart des entreprises fournissant des services d'IA.

Il existe une entreprise qui réduit les coûts d'infrastructure pour les sociétés fournissant des services d'IA. Si le développement de modèles exige des GPU haut de gamme, l'inférence repose uniquement sur la répétition de tâches prédéfinies à partir d'un modèle finalisé ; des GPU d'entrée de gamme suffisent donc. Partant de ce constat, aieev a considérablement réduit les coûts liés aux GPU en créant une infrastructure de cloud virtuel distribuée qui connecte les PC inactifs des particuliers et des cybercafés afin de fournir les ressources GPU nécessaires à l'inférence.

Park Se-jin, PDG d'aieev, a expliqué : « Le développement de grands modèles de langage nécessite des milliers, voire des dizaines de milliers de GPU, tandis que les services d'inférence n'en requièrent que quelques-uns. La réduction du coût de construction de l'infrastructure d'IA permettra à un plus grand nombre de personnes d'accéder à davantage de services d'IA. »

Le PDG Park a fondé aieev début 2024 après avoir constaté que les sociétés de services d'IA souffraient d'une pénurie de GPU en raison de l'utilisation massive de GPU pour le minage de cryptomonnaies.

Le PDG, M. Park, est titulaire d'un doctorat en génie logiciel de POSTECH et est actuellement professeur associé au département d'informatique et d'ingénierie de l'université Keimyung. L'équipe d'aieev est composée de spécialistes en génie logiciel issus de POSTECH, de KAIST et de l'université de Corée, dont la plupart cumulent plus de 15 ans d'expérience dans le secteur.

Depuis sa création, aieev a déposé dix brevets, décroché deux clients commerciaux et mène actuellement des essais de validation de concept (PoC) avec dix entreprises. En août dernier, elle a été sélectionnée pour la troisième promotion du programme d'accélération de startups en IA de SK Telecom. Afin de commercialiser sa technologie, l'entreprise prévoit une levée de fonds de série A au premier semestre 2026.

Nous avons rencontré le PDG Park Se-jin dans les bureaux d'aieev à Gangnam pour en savoir plus sur la manière dont les GPU inactifs sont connectés, sur le fonctionnement stable des GPU distribués et sur la vision d'aieev pour la réduction des coûts d'infrastructure d'IA.

Connecter les ordinateurs personnels à travers le monde

Alors, comment connecter le GPU inactif ?

En général, les ordinateurs personnels ou ceux des cybercafés n'ont pas d'adresse IP publique, ce qui les rend inaccessibles aux personnes extérieures. Comment se connecter à un ordinateur inaccessible ?

Aieev se connecte à un ordinateur via la technologie de traversée NAT. Lorsque l'ordinateur demande une connexion au serveur Aieev, le routeur ouvre automatiquement une connexion, permettant à Aieev de contrôler le GPU de l'ordinateur. En cas d'échec, la connexion est établie via un serveur intermédiaire (serveur relais). Aieev a finalisé ses tests techniques, connectant plus de 100 000 nœuds.

Supprimer le besoin d'un centre de données se traduit directement par une compétitivité accrue. Dans les centres de données traditionnels, 50 % des coûts d'électricité sont consacrés au refroidissement. La forte concentration d'équipements dans un espace réduit génère une chaleur considérable.

« Le personnel nécessaire à la construction, à l'exploitation et à la maintenance des centres de données est considérable. Aieev élimine le besoin de personnel dédié à la sécurité, aux opérations et à la maintenance. »

La connectivité n'est pas le seul facteur à prendre en compte. La gestion d'un réseau à grande échelle exige une communication efficace et une isolation des pannes entre chaque nœud.

« La gestion de nombreux nœuds exige bien plus qu'une simple connexion réseau. Une surveillance efficace de l'état de chaque nœud est essentielle, et en cas de panne d'un nœud, la charge de travail doit être rapidement transférée vers un autre nœud. »

Réduction des coûts grâce à un fonctionnement stable et à une technologie d'allocation automatique.

Dans un système distribué, la stabilité du service est primordiale.

L'exploitation des services d'IA nécessite de nombreuses bibliothèques open source. Si l'une d'entre elles est manquante ou incompatible, le service ne fonctionnera pas correctement. Pour pallier ce problème, aieev a développé la technologie des conteneurs. Cette technologie regroupe toutes les bibliothèques open source, les paramètres système et les dépendances nécessaires à l'exécution des modèles d'IA dans un seul package, garantissant ainsi une exécution stable des modèles dans un environnement cohérent, où que vous soyez.

Les grands services cloud et les centres de données centralisent tous les services en un seul lieu. Par conséquent, en cas de problème réseau ou de coupure de courant dans le centre de données, l'ensemble du service peut être interrompu. Il est donc indispensable de configurer la redondance et de mettre en place un système de reprise automatique afin d'éviter toute interruption de service, même en cas de défaillance d'un seul serveur.

Aieev automatise entièrement ce processus. Il suffit de télécharger un modèle sur la plateforme Aieev : tous les processus d'IA orientés services qui suivent, notamment la surveillance des performances, la configuration de la redondance et la récupération automatique, sont gérés automatiquement. Même en cas de problème sur un nœud, le planificateur interne bascule immédiatement la charge de travail vers un autre nœud, garantissant ainsi une continuité de service pour les utilisateurs.

Même en cas de panne sur un nœud, le planificateur interne transfère automatiquement la tâche vers un autre nœud et l'exécute. Du point de vue de l'utilisateur, il s'agit d'une panne physique, mais logiquement, elle est indétectable.

Une autre fonctionnalité importante est la mise à l'échelle automatique. Dans les environnements cloud classiques, les serveurs doivent être dimensionnés à l'avance pour répondre au trafic prévu. Le problème réside dans l'impossibilité de prédire le nombre d'utilisateurs. Par conséquent, les ressources sont réservées de manière prudente. Même si cela coûte plus cher, une interruption de service est bien plus préjudiciable.

L'allocation efficace des ressources en fonction de leur utilisation permet de réaliser d'importantes économies. aieev résout ce problème grâce à la mise à l'échelle automatique. Lorsque le trafic augmente, le nombre de nœuds et de conteneurs nécessaires est automatiquement augmenté, et inversement, lorsqu'il diminue, il est automatiquement réduit. De la même manière que davantage de personnel est déployé lors des pics d'activité et moins pendant les périodes creuses, les ressources peuvent être automatiquement ajustées en fonction du trafic. Cela se traduit par des économies substantielles. Les utilisateurs peuvent ajuster la sensibilité pour contrôler la vitesse de mise à l'échelle.

« Vous pouvez ajuster le taux de mise à l'échelle automatique en fonction des besoins de votre entreprise. Pour un client, cette technologie de mise à l'échelle automatique a permis de réaliser des économies d'environ 80 % par rapport aux services cloud traditionnels. »

aieev fournit une infrastructure opérationnelle automatisée qui garantit un fonctionnement stable, des performances optimales et une rentabilité accrue pour les modèles d'IA. Ainsi, même les startups peuvent immédiatement bénéficier d'une stabilité d'infrastructure comparable à celle des grandes entreprises.

Des start-ups aux grandes entreprises

aieev mène actuellement un projet pilote en collaboration avec une entreprise gérant des cybercafés à l'échelle nationale. À l'issue de ce projet, l'entreprise pourra utiliser les GPU inactifs répartis dans environ 4 000 cybercafés à travers le pays pour fournir des ressources de calcul aux sociétés de services d'IA. Des discussions sont également en cours avec des entreprises. La demande des entreprises nécessitant des ressources d'IA à petite échelle est en constante augmentation, et ces entreprises devraient devenir la clientèle cible principale d'aieev.

- Nuages d'inférence à faible coût : Air Cloud et Air Container

« Air Cloud » d'Aieev est une plateforme d'inférence IA à faible coût pouvant remplacer AWS. Elle est proposée en deux versions pour répondre aux besoins des clients.

Air Cloud Standard exploite la puissance des GPU inactifs des PC personnels et des cybercafés. Privilégiant la rentabilité, il permet aux startups et aux développeurs de tester et de déployer des modèles d'IA à moindre coût. Air Cloud Plus est conçu pour les entreprises exigeant une stabilité et des performances de niveau professionnel. Ce cluster distribué, composé de nœuds éprouvés et personnalisés, garantit une disponibilité de 99,99 %, assurant ainsi le fonctionnement stable des services d'IA critiques.

Les clients se voient allouer dynamiquement le nombre de GPU nécessaires en fonction de leur trafic et sont facturés à l'heure d'utilisation. Cela leur permet de s'adapter avec souplesse aux fluctuations imprévisibles du trafic. De plus, le tableau de bord d'aieev leur permet de surveiller en temps réel les performances et l'état des points de terminaison de l'API et d'analyser des journaux détaillés. Ils peuvent ainsi vérifier à tout moment le bon fonctionnement de leurs services d'IA et réagir rapidement en cas de problème.

- Service API IA compatible OpenAI « Air API »

« Air API » est une interface d'IA générative que les développeurs peuvent intégrer immédiatement à leurs services. Des fonctionnalités d'IA comme ChatGPT peuvent être implémentées simplement en appelant l'API, sans avoir à construire de modèles d'IA complexes.

L'API Air est facturée à l'appel, permettant aux entreprises de ne payer que ce qu'elles consomment réellement. Solution d'IA entièrement sans serveur, l'API Air permet aux clients de se concentrer exclusivement sur leur logique métier sans se soucier de la gestion de l'infrastructure ni de l'exploitation des serveurs. Elle s'adapte automatiquement à l'augmentation du trafic et réduit sa capacité en cas de diminution.

Air API prévoit un lancement officiel en 2026. Après son lancement, elle prévoit de prendre en charge divers modèles coréens basés sur la technologie LLM.

- Private Air Cloud : Optimisation des GPU inactifs pour les entreprises

Private Air Cloud est une solution qui centralise la gestion des ressources GPU dispersées au sein des grandes entreprises sur une plateforme unique et intégrée. Chaque département ou équipe acquérant des GPU en fonction de ses besoins, l'efficacité opérationnelle à l'échelle de l'entreprise s'avère complexe. Private Air Cloud résout ce problème. À l'instar d'Air Cloud qui agrège les GPU répartis dans le monde entier, Private Air Cloud gère en temps réel les GPU distribués au sein d'une entreprise et les alloue dynamiquement aux départements qui en ont besoin.

L'IA pour tous

Le nom aieev est un acronyme pour AI Equality, Everyone's Value (Égalité en IA, valeur pour tous). Il incarne le concept d'égalité en matière d'IA et la valeur qu'elle représente pour chacun.

« Je pense que le fossé informationnel va continuer de se creuser. Le manque d'accès à l'information, bien qu'invisible, va s'aggraver. Certains utilisent ChatGPT gratuitement, tandis que d'autres paient 300 000 wons par mois pour ChatGPT Plus. Il existe une différence significative en matière d'accès à l'information entre ces deux groupes. »

Les craintes de Park se concrétisent. À mesure que les services d'IA se développent dans tous les secteurs, le fossé entre les entreprises ayant accès à l'IA et celles qui n'y ont pas accès se creuse.

« Je crois que cet écart doit disparaître. Chacun devrait pouvoir profiter des avantages de l'IA. aieev vise à créer un monde où l'IA est accessible à tous, sans contrainte. Pour y parvenir, les coûts d'infrastructure doivent diminuer. »

Au-delà de la simple création de services à bas coût, aieev s'efforce de réduire les inégalités sociales grâce à la technologie. Pour y parvenir, l'innovation en matière d'infrastructures est essentielle. Si aieev relève le défi avec succès, le paysage de l'utilisation de l'IA sera radicalement transformé d'ici quelques années.

You must be logged in to post a comment.