Connectez les PC inactifs grâce à la traversée NAT et allouez automatiquement les ressources grâce à la mise à l'échelle automatique afin de réduire les coûts.

-Fourniture d'une infrastructure opérationnelle automatisée pour un fonctionnement stable, une optimisation des performances et une rentabilité des modèles d'IA.

Après la phase de test pilote, le service sera officiellement lancé l'année prochaine, et un investissement de série A est prévu pour le premier semestre 2026.

L'implémentation d'un service d'IA repose essentiellement sur l'entraînement et l'inférence. L'entraînement consiste à entraîner un modèle d'IA à reconnaître des schémas et à identifier des corrélations dans des données à grande échelle, tandis que l'inférence est le processus par lequel le modèle entraîné génère des réponses aux questions des utilisateurs et permet le fonctionnement effectif du service.

Le développement de services d'IA exige des ensembles de données massifs et une puissance de calcul élevée. Les centres de données doivent être équipés de milliers, voire de dizaines de milliers de GPU, et d'un réseau à haut débit pour optimiser la communication entre eux. Le coût unitaire d'un GPU dépasse 15 millions de wons, et peut parfois atteindre 20 millions. Ces coûts d'infrastructure considérables, notamment le coût élevé d'acquisition et d'exploitation des GPU, constituent un obstacle majeur à la rentabilité de la plupart des entreprises fournissant des services d'IA.

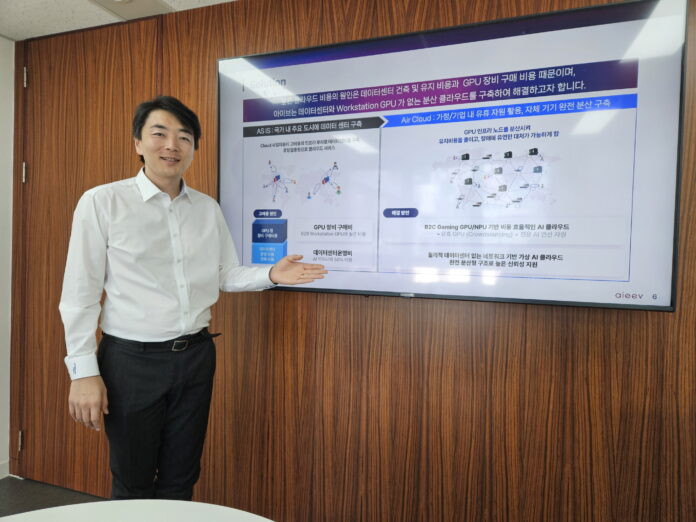

Il existe une entreprise qui réduit les coûts d'infrastructure pour les sociétés fournissant des services d'IA. Si le développement de modèles exige des GPU haut de gamme, l'inférence repose uniquement sur la répétition de tâches prédéfinies à partir d'un modèle finalisé ; des GPU d'entrée de gamme suffisent donc. Partant de ce constat, aieev a considérablement réduit les coûts liés aux GPU en créant une infrastructure de cloud virtuel distribuée qui connecte les PC inactifs des particuliers et des cybercafés afin de fournir les ressources GPU nécessaires à l'inférence.

Park Se-jin, PDG d'aieev, a expliqué : « Le développement de grands modèles de langage nécessite des milliers, voire des dizaines de milliers de GPU, tandis que les services d'inférence n'en requièrent que quelques-uns. La réduction du coût de construction de l'infrastructure d'IA permettra à un plus grand nombre de personnes d'accéder à davantage de services d'IA. »

Le PDG Park a fondé aieev début 2024 après avoir constaté que les sociétés de services d'IA souffraient d'une pénurie de GPU en raison de l'utilisation massive de GPU pour le minage de cryptomonnaies.

Le PDG, M. Park, est titulaire d'un doctorat en génie logiciel de POSTECH et est actuellement professeur associé au département d'informatique et d'ingénierie de l'université Keimyung. L'équipe d'aieev est composée de spécialistes en génie logiciel issus de POSTECH, de KAIST et de l'université de Corée, dont la plupart cumulent plus de 15 ans d'expérience dans le secteur.

Depuis sa création, aieev a déposé dix brevets, décroché deux clients commerciaux et mène actuellement des essais de validation de concept (PoC) avec dix entreprises. En août dernier, elle a été sélectionnée pour la troisième promotion du programme d'accélération de startups en IA de SK Telecom. Afin de commercialiser sa technologie, l'entreprise prévoit une levée de fonds de série A au premier semestre 2026.

Nous avons rencontré le PDG Park Se-jin dans les bureaux d'aieev à Gangnam pour en savoir plus sur la manière dont les GPU inactifs sont connectés, sur le fonctionnement stable des GPU distribués et sur la vision d'aieev pour la réduction des coûts d'infrastructure d'IA.

Connecter les ordinateurs personnels à travers le monde

Alors, comment connecter le GPU inactif ?

En général, les ordinateurs personnels ou ceux des cybercafés n'ont pas d'adresse IP publique, ce qui les rend inaccessibles aux personnes extérieures. Comment se connecter à un ordinateur inaccessible ?

Aieev se connecte à un ordinateur via la technologie de traversée NAT. Lorsque l'ordinateur demande une connexion au serveur Aieev, le routeur ouvre automatiquement une connexion, permettant à Aieev de contrôler le GPU de l'ordinateur. En cas d'échec, la connexion est établie via un serveur intermédiaire (serveur relais). Aieev a finalisé ses tests techniques, connectant plus de 100 000 nœuds.

Supprimer le besoin d'un centre de données se traduit directement par une compétitivité accrue. Dans les centres de données traditionnels, 50 % des coûts d'électricité sont consacrés au refroidissement. La forte concentration d'équipements dans un espace réduit génère une chaleur considérable.

« Le personnel nécessaire à la construction, à l'exploitation et à la maintenance des centres de données est considérable. Aieev élimine le besoin de personnel dédié à la sécurité, aux opérations et à la maintenance. »

La connectivité n'est pas le seul facteur à prendre en compte. La gestion d'un réseau à grande échelle exige une communication efficace et une isolation des pannes entre chaque nœud.

« La gestion de nombreux nœuds exige bien plus qu'une simple connexion réseau. Une surveillance efficace de l'état de chaque nœud est essentielle, et en cas de panne d'un nœud, la charge de travail doit être rapidement transférée vers un autre nœud. »

Réduction des coûts grâce à un fonctionnement stable et à une technologie d'allocation automatique.

Dans un système distribué, la stabilité du service est primordiale.

L'exploitation des services d'IA nécessite de nombreuses bibliothèques open source. Si l'une d'entre elles est manquante ou incompatible, le service ne fonctionnera pas correctement. Pour pallier ce problème, aieev a développé la technologie des conteneurs. Cette technologie regroupe toutes les bibliothèques open source, les paramètres système et les dépendances nécessaires à l'exécution des modèles d'IA dans un seul package, garantissant ainsi une exécution stable des modèles dans un environnement cohérent, où que vous soyez.

Les grands services cloud et les centres de données centralisent tous les services en un seul lieu. Par conséquent, en cas de problème réseau ou de coupure de courant dans le centre de données, l'ensemble du service peut être interrompu. Il est donc indispensable de configurer la redondance et de mettre en place un système de reprise automatique afin d'éviter toute interruption de service, même en cas de défaillance d'un seul serveur.

Aieev automatise entièrement ce processus. Il suffit de télécharger un modèle sur la plateforme Aieev : tous les processus d'IA orientés services qui suivent, notamment la surveillance des performances, la configuration de la redondance et la récupération automatique, sont gérés automatiquement. Même en cas de problème sur un nœud, le planificateur interne bascule immédiatement la charge de travail vers un autre nœud, garantissant ainsi une continuité de service pour les utilisateurs.

Même en cas de panne sur un nœud, le planificateur interne transfère automatiquement la tâche vers un autre nœud et l'exécute. Du point de vue de l'utilisateur, il s'agit d'une panne physique, mais logiquement, elle est indétectable.

Une autre fonctionnalité importante est la mise à l'échelle automatique. Dans les environnements cloud classiques, les serveurs doivent être dimensionnés à l'avance pour répondre au trafic prévu. Le problème réside dans l'impossibilité de prédire le nombre d'utilisateurs. Par conséquent, les ressources sont réservées de manière prudente. Même si cela coûte plus cher, une interruption de service est bien plus préjudiciable.

L'allocation efficace des ressources en fonction de leur utilisation permet de réaliser d'importantes économies. aieev résout ce problème grâce à la mise à l'échelle automatique. Lorsque le trafic augmente, le nombre de nœuds et de conteneurs nécessaires est automatiquement augmenté, et inversement, lorsqu'il diminue, il est automatiquement réduit. De la même manière que davantage de personnel est déployé lors des pics d'activité et moins pendant les périodes creuses, les ressources peuvent être automatiquement ajustées en fonction du trafic. Cela se traduit par des économies substantielles. Les utilisateurs peuvent ajuster la sensibilité pour contrôler la vitesse de mise à l'échelle.

« Vous pouvez ajuster le taux de mise à l'échelle automatique en fonction des besoins de votre entreprise. Pour un client, cette technologie de mise à l'échelle automatique a permis de réaliser des économies d'environ 80 % par rapport aux services cloud traditionnels. »

aieev fournit une infrastructure opérationnelle automatisée qui garantit un fonctionnement stable, des performances optimales et une rentabilité accrue pour les modèles d'IA. Ainsi, même les startups peuvent immédiatement bénéficier d'une stabilité d'infrastructure comparable à celle des grandes entreprises.

Des start-ups aux grandes entreprises

aieev mène actuellement un projet pilote en collaboration avec une entreprise gérant des cybercafés à l'échelle nationale. À l'issue de ce projet, l'entreprise pourra utiliser les GPU inactifs répartis dans environ 4 000 cybercafés à travers le pays pour fournir des ressources de calcul aux sociétés de services d'IA. Des discussions sont également en cours avec des entreprises. La demande des entreprises nécessitant des ressources d'IA à petite échelle est en constante augmentation, et ces entreprises devraient devenir la clientèle cible principale d'aieev.

- Nuages d'inférence à faible coût : Air Cloud et Air Container

« Air Cloud » d'Aieev est une plateforme d'inférence IA à faible coût pouvant remplacer AWS. Elle est proposée en deux versions pour répondre aux besoins des clients.

Air Cloud Standard exploite la puissance des GPU inactifs des PC personnels et des cybercafés. Privilégiant la rentabilité, il permet aux startups et aux développeurs de tester et de déployer des modèles d'IA à moindre coût. Air Cloud Plus est conçu pour les entreprises exigeant une stabilité et des performances de niveau professionnel. Ce cluster distribué, composé de nœuds éprouvés et personnalisés, garantit une disponibilité de 99,99 %, assurant ainsi le fonctionnement stable des services d'IA critiques.

Les clients se voient allouer dynamiquement le nombre de GPU nécessaires en fonction de leur trafic et sont facturés à l'heure d'utilisation. Cela leur permet de s'adapter avec souplesse aux fluctuations imprévisibles du trafic. De plus, le tableau de bord d'aieev leur permet de surveiller en temps réel les performances et l'état des points de terminaison de l'API et d'analyser des journaux détaillés. Ils peuvent ainsi vérifier à tout moment le bon fonctionnement de leurs services d'IA et réagir rapidement en cas de problème.

- Service API IA compatible OpenAI « Air API »

« Air API » est une interface d'IA générative que les développeurs peuvent intégrer immédiatement à leurs services. Des fonctionnalités d'IA comme ChatGPT peuvent être implémentées simplement en appelant l'API, sans avoir à construire de modèles d'IA complexes.

L'API Air est facturée à l'appel, permettant aux entreprises de ne payer que ce qu'elles consomment réellement. Solution d'IA entièrement sans serveur, l'API Air permet aux clients de se concentrer exclusivement sur leur logique métier sans se soucier de la gestion de l'infrastructure ni de l'exploitation des serveurs. Elle s'adapte automatiquement à l'augmentation du trafic et réduit sa capacité en cas de diminution.

Air API prévoit un lancement officiel en 2026. Après son lancement, elle prévoit de prendre en charge divers modèles coréens basés sur la technologie LLM.

- Private Air Cloud : Optimisation des GPU inactifs pour les entreprises

Private Air Cloud est une solution qui centralise la gestion des ressources GPU dispersées au sein des grandes entreprises sur une plateforme unique et intégrée. Chaque département ou équipe acquérant des GPU en fonction de ses besoins, l'efficacité opérationnelle à l'échelle de l'entreprise s'avère complexe. Private Air Cloud résout ce problème. À l'instar d'Air Cloud qui agrège les GPU répartis dans le monde entier, Private Air Cloud gère en temps réel les GPU distribués au sein d'une entreprise et les alloue dynamiquement aux départements qui en ont besoin.

L'IA pour tous

Le nom aieev est un acronyme pour AI Equality, Everyone's Value (Égalité en IA, valeur pour tous). Il incarne le concept d'égalité en matière d'IA et la valeur qu'elle représente pour chacun.

« Je pense que le fossé informationnel va continuer de se creuser. Le manque d'accès à l'information, bien qu'invisible, va s'aggraver. Certains utilisent ChatGPT gratuitement, tandis que d'autres paient 300 000 wons par mois pour ChatGPT Plus. Il existe une différence significative en matière d'accès à l'information entre ces deux groupes. »

Les craintes de Park se concrétisent. À mesure que les services d'IA se développent dans tous les secteurs, le fossé entre les entreprises ayant accès à l'IA et celles qui n'y ont pas accès se creuse.

« Je crois que cet écart doit disparaître. Chacun devrait pouvoir profiter des avantages de l'IA. aieev vise à créer un monde où l'IA est accessible à tous, sans contrainte. Pour y parvenir, les coûts d'infrastructure doivent diminuer. »

Au-delà de la simple création de services à bas coût, aieev s'efforce de réduire les inégalités sociales grâce à la technologie. Pour y parvenir, l'innovation en matière d'infrastructures est essentielle. Si aieev relève le défi avec succès, le paysage de l'utilisation de l'IA sera radicalement transformé d'ici quelques années.

You must be logged in to post a comment.