– 自社開発したTriple Helix AIエンジンで検証された論文検索

博士課程中のキム・ヨングは重要な学会発表を控えている。発表までの残り時間はたった一ヶ月。 「神経可塑性研究動向」というテーマを定めたが、最新資料を収集することが難しかった。キム・ヨングが選んだ解決策がtlootoだ。 tlootoのSaaSサービスに「神経可塑性最近3年研究の主な発見は?」と質問を投げると、驚くほど速い答えが戻ってきた。世界の主要研究機関の最新動向、新しい方法論、学界の注目すべき発見を体系的にまとめることができた。キム・ヨングは該当資料で研究論文を作成し、学会で成功的に発表することができた。

最近、AI技術の発展で必要な資料を見つけて生成することが容易になった。しかし、学術分野では根本的な問題がある。一般生成型AIは、存在しない論文を引用したり、誤った情報を事実のように提示する幻覚(hallucination)現象である。学術研究ではこれは致命的です。

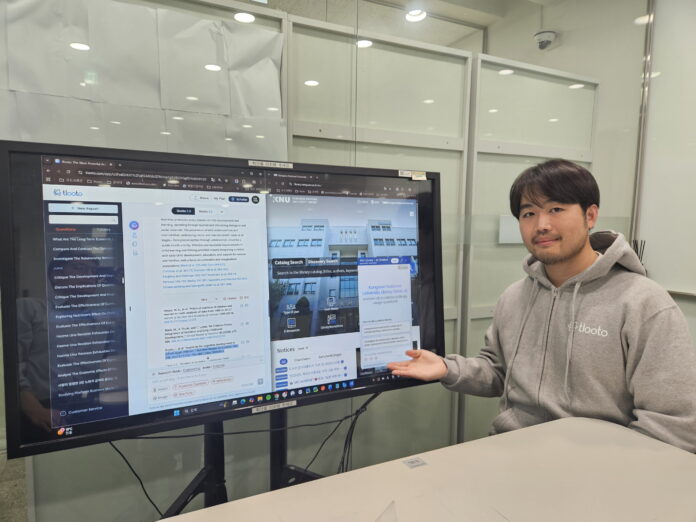

2023年にローンチした学術AI「tlooto」は、200億を超える学術論文からユーザーの質問に最も適切な回答を見つけ、その根拠となった論文を引用しながら信頼できる情報を提供する。研究者たちが膨大な学術資料を毎日検討することを自動化し、繰り返しかつ時間のかかる作業を減らす。

「多くの研究者が参考文献を見つけ、整理し、要約する機械的な作業に時間を無駄にしています。tlootoはこれを解決してくれるAIエンジンです」

tlootoのMAU(月間アクティブユーザー)は100万人に達する。ユーザーの99%が英語圏で、海外トラフィックが96%に達する。

tlootoのTriple Helixアルゴリズム、学術論文データベースの統合、信頼度ベースの回答システムなどが学術分野に特化した技術として認められている。 CODE CRAINはこうした技術力を認められ、2024年TechCrunch Disruptに韓国代表スタートアップに選定され、2025年CESではR&D優秀企業に選定された。去る8月にはSKテレコムの「AI Startup Accelerator 3期」プログラムに最終選定された。

学術分野特化型AIエンジン Triple Helix AI

「tlootoを開発する際に最も重要だと思ったのが正確です。

tlootoの「Triple Helix AI」エンジンは、200億以上の学術論文データベースでユーザーの質問に関連する論文を検索し、それらを自動的に分析・総合して学術的に洗練された回答を生成し、すべての内容に信頼できる論文引用を添付するアルゴリズムだ。単純な検索エンジンではなく、大規模な学術データを意味ベースで理解し、様々な論文の主張を比較・分析し、総合的な学術的洞察を提供するAIベースの学術研究補助システムで、検索(Search)・分析(Analysis)・要約(Summarization)・引用(Citation)が有機的に連携して研究者がサポートする。その結果、研究者が論文検索と情報収集に費やした時間を大幅に短縮し、その時間を批判的思考と創造的研究に集中できるようにすることが、Triple Helix AIエンジンの重要な目標だ。

学術研究に必要な資料は全てこちら

「tlooto SaaS」はCODE CRAINが提供するコアサービスで、個人研究者、大学院生、学部生、そして学問に関心のある一般人、企業の研究チームが購読方式で利用できるサービスで、月9.99ドルから29.99ドルまで価格帯が多様だ。

- クイック論文検索

Triple Helix AIエンジンは、200億以上の学術論文データベースで関連性の高い論文を見つけます。 Triple Helix AIの検索は、キーワードマッチングではなくセマンティック検索で機能します。ユーザーの質問の深い意味を理解し、同じ意味を異なって表現するすべての論文を検索し、関連度と信頼度順で最も高い論文(最上位ジャーナル、引用度高い)をまず選別する。

- AI総合分析

選択された論文の各研究方法論と発見を分析し、統合された回答を生成します。検索された論文が互いに同じ主張をするのか、別の主張をしているのか、どの部分を強調したのか、時間によって研究トレンドはどのように変化したのかなど、多層的な関係を把握する。

- 要約

分析された論文の内容を自動的にまとめて、ユーザーの質問に対する明確な答えを生成します。検索された論文全体から全体像を抽出し、構造化された回答を作成し、論文が明記しない暗黙の意味まで導き出し、新しい洞察を創出する。

- 自動引用

生成された回答にはソースが自動的に表示され、ユーザーは引用情報をそのまま自分の論文にコピーすることができる。各文がどの論文から来たのかを明示し、その論文が最上位ジャーナルであるか、他の研究者に何回引用されたかを一緒に表示する。ユーザーは信頼性を一目で判断でき、ソース論文に直接移動することができる。

- さまざまな出力フォーマット

要約、説明、表、グラフなど、ユーザーが望む形式で回答を受け、すぐにレポートや論文に活用できる。

- 保存と管理

以前の検索結果をプロジェクト別に保存して、後ですばやくアクセスできます。長期研究プロジェクトで特に有用です。

大学生活で必要なものは何でも聞いてください

「tlooto Copilot」は、図書館や教育機関のウェブサイトにプラグインの形で簡単に設置できるAIチャットボットだ。現在20の大学図書館に導入され、今年末までに50の大学に拡大する予定だ。

K大学図書館はtlooto Copilot導入後のウェブサイト利用率と滞留時間が15%増加した。シン代表は「既存の図書館は本を保管して検索する機能にとどまったが、tlootoが搭載され、図書館は単純な資料保管所ではなく、学生や研究者の知的仲間として機能することになった」と説明した。

tlooto Copilotは論文検索だけでなく、「図書館が何時に開かれている?」などの学生生活全体の質問に答える。大学ホームページのウェブページのテキスト、添付ファイル、お知らせ、画像などすべてのデータを自動的に収集し、ほぼ毎日情報を更新して最新性を維持している。収集したデータは、トリプルヘリックスAIエンジンを通じて信頼度評価、最新性レビュー、重要度判別を行った後、検索システムが理解できる形に再構成される。

シン代表は「一般チャットボットサービスはすべての業種を扱おうとするため、ホームページの自動収集などの機能を提供することは難しいですが、CODE CRAINは最初から大学のみターゲットに設計し、大学の行政文書と構造を深く理解していてこれが可能です」と説明した。

現地の学術データの確保と学術文献マップの構築に拡張

現在、tlootoが検索する200億の学術データは、英語圏の主流分野(STEM)に集中している。各国の文化・芸術・歴史・哲学のような非主流分野の学術資料は現地言語でのみ存在し、グローバル学界ではほとんど知られていない。 CODE CRAINは今後、各国の大学・図書館・博物館で現地言語論文を自動的にクロールして精製し、グローバルデータベースに統合する計画だ。そうすれば、各地域のユニークな学問がグローバル舞台で認められる包括的学術生態系を構築することができる。

二つ目は「学術文献マップ生成」である。 CODE CRAINはテキストベースの検索を超えて、論文・著者・キーワード間の関係をインタラクティブなネットワークマップで視覚化する機能を開発する計画だ。研究テーマを決めるとき、技術開発の方向を決めるとき、政策立案者が未来重点分野を把握するとき、現在の研究地形を体系的に理解し、研究格差を発見し、革新的なアイデアを導出することを支援するツールになると期待される。

知識民主化のために

CODE CRAINの究極の目標は「高度な知識と一般人の間隔を減らすこと」にある。 AIがそれを可能にすることができれば、非常に意味のあることになるでしょう。 tlootoを通じて誰でも高級知識にアクセスできるということは、知識が真の公共財(public good)になる時代を開くことができるという意味だ。

今後、CODE CRAINがグローバル市場でどのように成長していくのか、そしてその過程でどれだけ多くの個人研究者や学生が恩恵を受けるのか見守らなければならないようだ。

You must be logged in to post a comment.