利用 NAT 穿越连接空闲 PC,并利用自动扩展功能自动分配资源,从而降低成本。

-为人工智能模型的稳定运行、性能优化和成本效益提供自动化运行基础设施。

试点测试完成后,该服务将于明年正式推出,A 轮融资预计将于 2026 年上半年进行。

人工智能服务实现的核心是训练和推理。训练是指训练人工智能模型以识别大规模数据中的模式和关联性的过程,而推理是指训练好的模型生成用户问题的答案以及实际运行服务的过程。

开发人工智能服务需要海量数据集和高性能计算。数据中心必须配备数千甚至数万个GPU以及高带宽网络,以优化GPU间的通信。每个GPU的成本超过1500万韩元,有时甚至超过2000万韩元。这些巨额基础设施成本,尤其是GPU的高昂购置和运营成本,是阻碍大多数人工智能服务提供商实现盈利的关键因素。

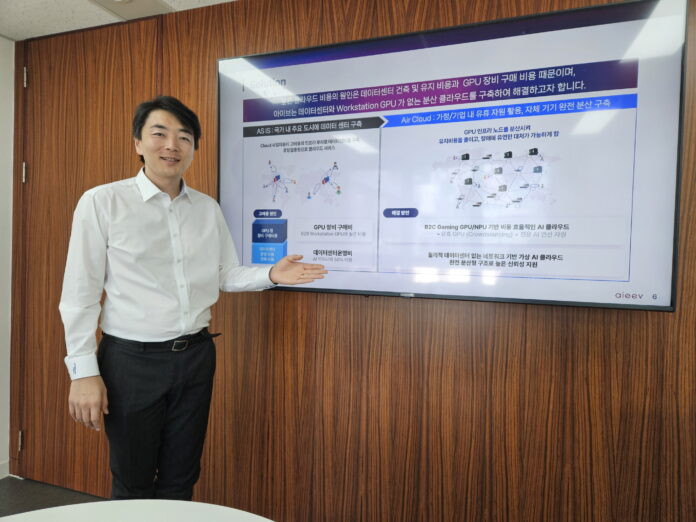

有一家公司致力于降低人工智能服务提供商的基础设施成本。虽然模型开发需要高端GPU,但推理仅依赖于重复执行已完成模型中预定义的任务,因此即使是低端GPU也足以胜任。基于此,aieev通过构建分布式虚拟云基础设施,将家庭和网吧中闲置的PC连接起来,提供推理所需的GPU资源,从而大幅降低了GPU成本。

aieev首席执行官朴世镇解释说:“开发大型语言模型需要成千上万个GPU,但推理服务只需要几个。降低构建人工智能基础设施的成本将使更多人能够获得更多的人工智能服务。”

CEO Park 在 2024 年初创立了 aieev,当时他发现由于大量 GPU 用于加密货币挖矿,人工智能服务公司正面临 GPU 短缺的问题。

朴社长在浦项科技大学获得系统软件博士学位,目前担任启明大学计算机科学与工程系兼职教授。aieev团队由来自浦项科技大学、韩国科学技术院和高丽大学的系统软件专家组成,其中大多数人拥有超过15年的行业经验。

自成立以来,aieev 已申请了十项专利,获得了两家商业客户,目前正在与十家公司进行概念验证 (PoC) 试验。去年八月,该公司入选 SK Telecom 的“人工智能创业加速器第三期”。为了实现技术商业化,该公司计划在 2026 年上半年进行 A 轮融资。

我们在 aieev 位于江南的办公室与 CEO 朴世镇会面,了解了闲置 GPU 的连接方式、分布式 GPU 的稳定运行方式,以及 aieev 在降低 AI 基础设施成本方面的愿景。

连接世界各地的个人电脑

那么,我们如何连接空闲的GPU呢?

通常情况下,个人电脑或网吧的电脑没有公网IP地址,外人无法访问。那么,如何连接到一台无法访问的电脑呢?

aieev 通过 NAT 穿透技术连接到个人电脑。当目标个人电脑请求连接到 aieev 服务器时,路由器会自动建立连接,从而允许 aieev 控制该电脑的 GPU。如果此方法失败,则会通过中间服务器(中继服务器)建立连接。aieev 已完成技术测试,连接了超过 10 万个节点。

无需建设数据中心就能直接降低成本。在传统数据中心,50% 的电力成本都用于冷却。由于大量设备被塞进狭小的空间,会产生大量的热量。

“仅数据中心的建设、运营和维护就需要相当多的人员。Aieev 消除了对专门负责安全、运营和维护人员的需求。”

连接性并非故事的全部。管理大型网络还需要各节点之间高效的通信和故障隔离。

“管理众多节点需要的不仅仅是简单的网络连接。对每个节点的状态进行高效监控至关重要,如果某个节点发生故障,必须迅速将工作负载转移到另一个节点。”

通过稳定运行和自动分配技术实现成本节约。

分布式系统中最重要的是服务稳定性。

运行人工智能服务需要大量的开源库,如果缺少任何库或库版本不兼容,服务将无法正常运行。为了解决这个问题,aieev 开发了容器技术。容器技术将运行人工智能模型所需的所有开源库、系统设置和依赖项打包到一个单独的软件包中,从而能够在一致的环境中随时随地稳定地执行模型。

大型云服务和数据中心将所有服务集中在一个位置。因此,如果数据中心发生网络问题或断电,整个服务都可能中断。所以,必须配置冗余机制,并部署自动恢复系统,以防止即使单个服务器发生故障也导致服务中断。

Aieev 完全自动化了整个流程。只需将模型上传到 Aieev 平台,所有后续的 AI 服务相关流程,包括性能监控、冗余配置和自动恢复,都将自动完成。即使某个节点出现问题,内部调度器也会立即将工作负载切换到另一个节点,因此用户不会感受到任何逻辑中断。

即使某个节点发生故障,内部调度器也会自动将任务切换到另一个节点并执行。从用户的角度来看,这表现为物理故障,但从逻辑上讲,这种故障是无法检测到的。

另一个重要特性是自动扩缩容。在典型的云环境中,服务器必须预先配置以满足预期流量。问题在于用户数量无法预测。因此,资源通常会预先进行保守配置。即使成本更高,服务中断的危害也远大于资源不足。

根据使用情况高效分配资源可以显著节省成本。aieev 通过自动扩缩容解决了这个问题。随着流量增加,所需的节点和容器会自动扩容;随着流量减少,则会自动缩容。正如在客户高峰期部署更多员工,在低谷期减少员工一样,资源也可以根据流量自动扩容或缩减。这可以转化为显著的成本节约。用户可以调整灵敏度来控制扩容速率。

“您可以根据业务需求调整自动扩展速率。对于一位客户而言,与传统云服务相比,这项自动扩展技术帮助他们节省了约 80% 的成本。”

aieev 提供自动化运维基础设施,确保 AI 模型稳定运行、性能优化和成本效益。这意味着即使是初创公司也能立即获得与大型企业相媲美的基础设施稳定性。

从初创公司到大型企业

aieev目前正与一家运营全国网吧的公司合作开展试点项目。项目完成后,aieev将能够利用分布在全国约4000家网吧的闲置GPU,为AI服务公司提供计算资源。aieev也正积极与各公司洽谈合作事宜。尤其值得注意的是,对小规模AI资源需求的公司正在稳步增长,预计这些公司将成为aieev的主要目标客户。

- 低成本推理云:空中云和空中集装箱

aieev 的“Air Cloud”是一个低成本的 AI 推理平台,可以替代 AWS。它提供两种选项以满足客户的不同需求。

Air Cloud Standard 通过众包个人电脑和网吧的闲置 GPU 运行。它优先考虑成本效益,使初创公司和开发者能够以最低成本测试和部署 AI 模型。Air Cloud Plus 专为需要企业级稳定性和性能的企业而设计。它是一个由经过验证的定制节点组成的分布式集群,可保证 99.99% 的可用性,从而确保即使是关键任务型 AI 服务也能稳定运行。

系统会根据客户的流量动态分配所需的GPU数量,并按使用时间计费。这使客户能够灵活应对不可预测的流量波动。此外,aieev的控制面板允许客户实时监控API端点的性能和状态,并分析详细的日志。这使得客户可以随时验证其AI服务是否正常运行,并在必要时快速响应问题。

- 兼容OpenAI的AI API服务“Air API”

“Air API”是一个生成式人工智能接口,开发者可以立即将其集成到自己的服务中。诸如ChatGPT之类的AI功能只需调用该API即可实现,无需构建复杂的AI模型。

Air API 按调用次数计费,企业只需为实际使用的资源付费。Air API 是一款完全无服务器的 AI 解决方案,让客户能够专注于业务逻辑,无需担心基础设施管理或服务器运维。它会随着流量的增加自动扩展,并随着流量的减少自动缩减。

Air API 计划于 2026 年正式上线。上线后,计划支持各种基于韩国 LLM 的模型。

- 私有空中云:优化企业闲置GPU

Private Air Cloud 是一款解决方案,它将大型企业分散的 GPU 资源整合到一个统一的平台上进行管理。由于每个部门或团队都根据自身需求获取 GPU,因此难以实现高效的全公司运营。Private Air Cloud 从根本上解决了这个问题。正如 Air Cloud 聚合全球各地的 GPU 一样,Private Air Cloud 可以实时管理公司内部的分布式 GPU,并动态地将其分配给需要的部门。

人人都能用上人工智能

aieev 这个名字是 AI Equality, Everyone's Value(人工智能平等,人人价值)的缩写,它体现了人工智能平等和人人价值的含义。

我认为信息鸿沟会继续扩大。信息获取方面的差距虽然看不见,但却会不断加深。有些人免费使用 ChatGPT,而有些人每月却要支付 30 万韩元购买 ChatGPT Plus。这两者在信息获取方面存在着显著差异。

朴先生的担忧正在成为现实。随着人工智能服务在各行各业的扩展,能够使用人工智能的公司和无法使用人工智能的公司之间的差距正在扩大。

我认为这种差距应该消除。每个人都应该能够享受到人工智能带来的好处。aieev 的目标是创建一个人人都能轻松使用人工智能的世界。为了实现这一目标,基础设施成本必须降低。

除了提供低成本服务之外,aieev 还试图通过技术弥合社会鸿沟。要实现这一目标,基础设施创新至关重要。如果 aieev 的挑战成功,人工智能的应用格局将在几年内发生翻天覆地的变化。

You must be logged in to post a comment.