AI 경량화 및 최적화 기술 기업 노타(대표 채명수)가 11월 5일부터 7일까지 일산 킨텍스(KINTEX)에서 열리는 ‘디지털퓨처쇼 2025’에 참가해 AI 모델 최적화 기술을 공개한다고 밝혔다.

노타는 행사에서 AI 모델 최적화 플랫폼 ‘넷츠프레소’를 기반으로 다양한 엣지 디바이스에서 대규모 AI 모델을 실행할 수 있는 체험형 부스를 운영할 예정이다.

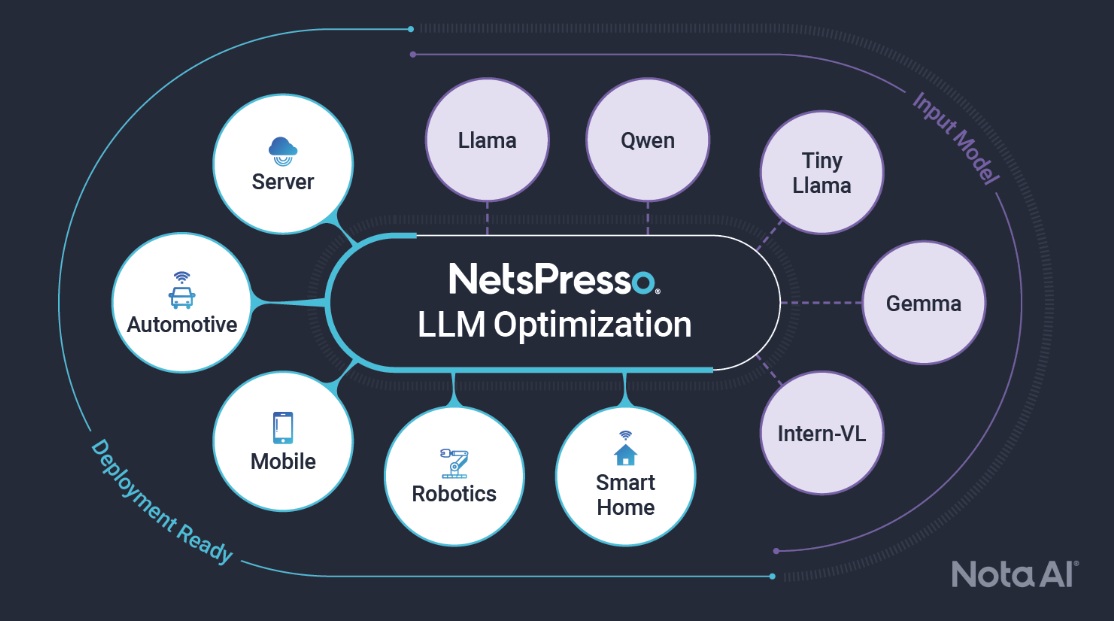

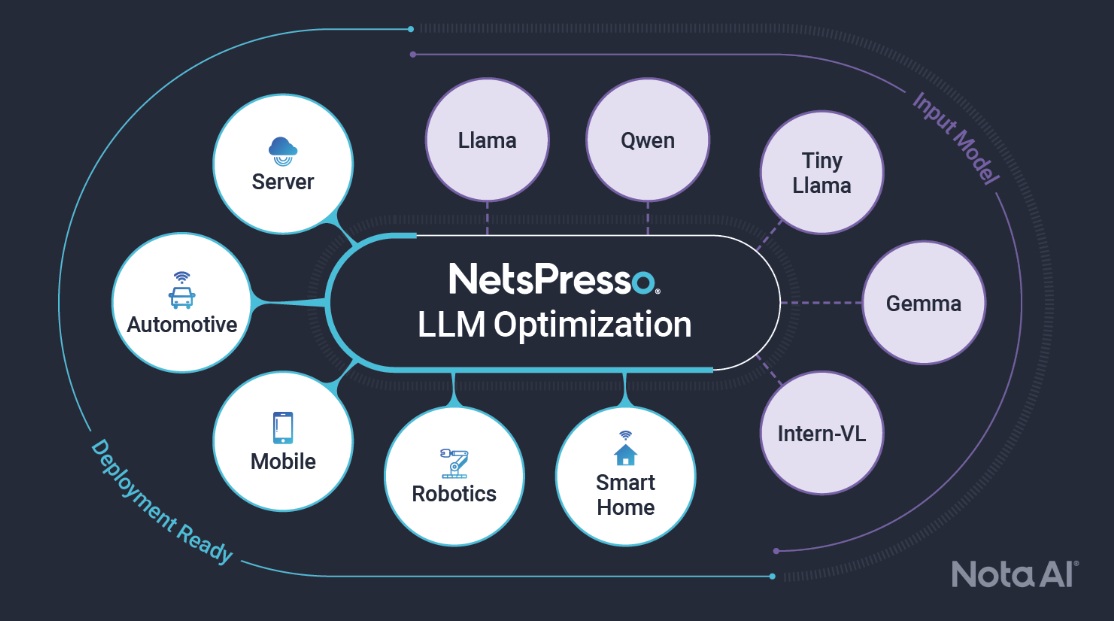

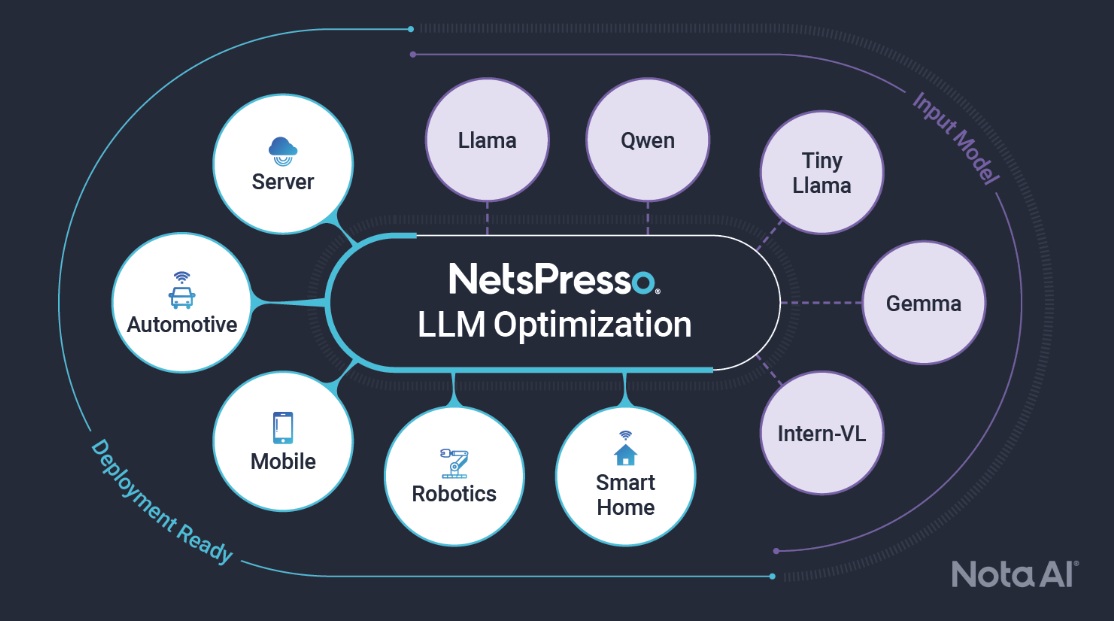

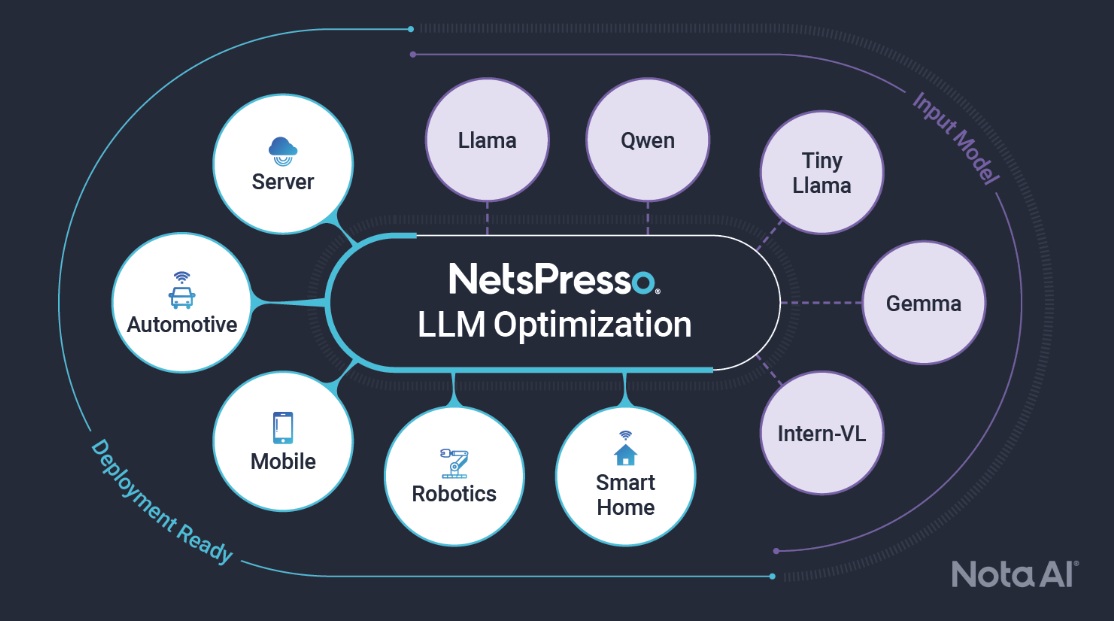

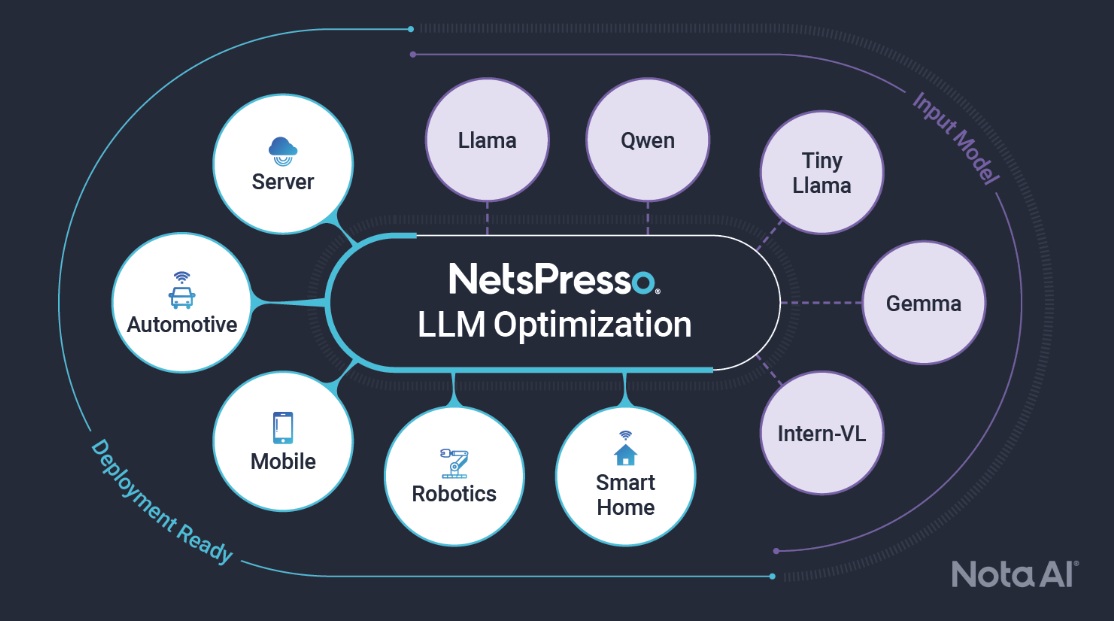

이번 전시에서는 저전력 디바이스에서 대규모 언어모델(LLM)과 비전언어모델(VLM)을 최적화하는 LLM 최적화 서비스를 선보인다. 해당 서비스는 모델 성능을 유지하면서 빠른 추론 속도를 제공하며, GPU 없이도 엣지 환경에서 대규모 AI 모델을 실행할 수 있도록 설계됐다. 이를 통해 기업은 기존 제품에 고성능 AI 기능을 적용하면서 GPU 서버 비용과 전력 제약 문제를 완화할 수 있다.

방문객은 다양한 엣지 디바이스에서 문서를 업로드하고 질문하면, 넷츠프레소를 통해 최적화된 LLM 모델이 문서를 이해하고 답변하는 기능을 체험할 수 있다. 또한 VLM 모델 최적화 서비스의 엣지 환경 구현 경험과 무료 컨설팅 신청 기회도 제공된다.

노타 관계자는 “이번 전시는 AI 최적화 기술이 기존 기기에서 효율적으로 구현되는 방식을 관람객이 직접 체험할 수 있도록 구성했다”며, “체험을 통해 AI 경량화 및 최적화 기술의 이해를 높이고, 자사 제품 적용 가능성을 확인할 수 있을 것”이라고 말했다.

- 관련 기사 더 보기

Nota to Participate in 'Digital Future Show 2025'

Nota (CEO Myung-soo Chae), an AI lightweight and optimization technology company, announced that it will participate in the 'Digital Future Show 2025' held at KINTEX in Ilsan from November 5th to 7th and unveil its AI model optimization technology.

At the event, Nota will operate an experiential booth that can run large-scale AI models on various edge devices based on the AI model optimization platform 'Netpresso'.

This exhibition showcases an LLM optimization service that optimizes large-scale language models (LLMs) and vision language models (VLMs) on low-power devices. This service delivers fast inference speeds while maintaining model performance, and is designed to enable the execution of large-scale AI models in edge environments without the need for GPUs. This allows companies to integrate high-performance AI capabilities into existing products while alleviating GPU server costs and power constraints.

Visitors can upload documents and ask questions from various edge devices, allowing Netpresso to experience optimized LLM models understanding and responding to documents. They can also experience implementing VLM model optimization services in edge environments and apply for free consulting.

A Nota representative said, “This exhibition is designed to allow visitors to directly experience how AI optimization technology can be efficiently implemented on existing devices,” and added, “Through this experience, they will be able to increase their understanding of AI lightweighting and optimization technology and confirm the applicability of our products.”

- See more related articles

野田、「デジタルフューチャーショー2025」に参加

AI軽量化および最適化技術 企業のノータ(代表チェ・ミョンス)が11月5日から7日まで一山キンテックス(KINTEX)で開かれる'デジタルフューチャーショー2025'に参加してAIモデル最適化技術を公開すると明らかにした。

ノータはイベントでAIモデル最適化プラットフォーム「NetzPreso」を基盤に、様々なエッジデバイスで大規模なAIモデルを実行できる体験型ブースを運営する予定だ。

今回の展示では、低電力デバイスで大規模言語モデル(LLM)と非電言語モデル(VLM)を最適化するLLM最適化サービスを披露する。同サービスはモデル性能を維持しながら高速推論速度を提供し、GPUなしでエッジ環境で大規模なAIモデルを実行できるように設計された。これにより、企業は既存製品に高性能AI機能を適用しながら、GPUサーバーのコストと電力制約の問題を緩和することができる。

訪問者はさまざまなエッジデバイスから文書をアップロードして質問すると、NetzPressoを通じて最適化されたLLMモデルが文書を理解して回答する機能を体験することができる。また、VLMモデル最適化サービスのエッジ環境実装体験と無料コンサルティング申請機会も提供される。

野田関係者は「今回の展示は、AI最適化技術が既存の機器で効率的に実装される方法を観覧客が直接体験できるように構成した」とし、「体験を通じてAI軽量化および最適化技術の理解を高め、自社製品の適用可能性を確認できるだろう」と述べた。

- 関連記事をもっと見る

Nota 将参加“2025 年数字未来展”

人工智能轻量级优化技术公司 Nota(CEO 蔡明洙)宣布,将参加 11 月 5 日至 7 日在韩国日山 KINTEX 举办的“2025 数字未来展”,并推出其人工智能模型优化技术。

在本次活动中,Nota 将运营一个体验式展位,该展位可以基于人工智能模型优化平台“Netpresso”在各种边缘设备上运行大规模人工智能模型。

本次展览重点展示了一项LLM优化服务,该服务可在低功耗设备上优化大规模语言模型(LLM)和视觉语言模型(VLM)。这项服务在保持模型性能的同时,实现了快速推理,旨在无需GPU即可在边缘环境中运行大规模AI模型。这使得企业能够将高性能AI功能集成到现有产品中,同时降低GPU服务器的成本和功耗限制。

访客可以通过各种边缘设备上传文档并提出问题,体验由 Netpresso 提供支持的优化 LLM 模型理解和响应文档的能力。他们还可以体验在边缘环境中实施 VLM 模型优化服务,并申请免费咨询。

Nota 的一位代表表示:“本次展览旨在让参观者直接体验如何在现有设备上高效地应用 AI 优化技术。”他还补充道:“通过这种体验,他们将能够加深对 AI 轻量级和优化技术的理解,并确认我们产品的适用性。”

- 查看更多相关文章

Avis de participation au « Digital Future Show 2025 »

Nota (PDG Myung-soo Chae), une société de technologie d'IA légère et d'optimisation, a annoncé qu'elle participera au « Digital Future Show 2025 » qui se tiendra au KINTEX à Ilsan du 5 au 7 novembre et y dévoilera sa technologie d'optimisation de modèles d'IA.

Lors de cet événement, Nota exploitera un stand expérientiel capable d'exécuter des modèles d'IA à grande échelle sur divers appareils périphériques grâce à la plateforme d'optimisation de modèles d'IA « Netpresso ».

Cette exposition présente un service d'optimisation LLM qui optimise les modèles de langage à grande échelle (LLM) et les modèles de langage visuel (VLM) sur des appareils basse consommation. Ce service offre des vitesses d'inférence rapides tout en préservant les performances du modèle et est conçu pour permettre l'exécution de modèles d'IA à grande échelle en périphérie de réseau, sans nécessiter de GPU. Les entreprises peuvent ainsi intégrer des fonctionnalités d'IA hautes performances à leurs produits existants tout en réduisant les coûts et les contraintes énergétiques liés aux serveurs GPU.

Les visiteurs peuvent télécharger des documents et poser des questions depuis différents appareils périphériques, ce qui permet à Netpresso de tester l'optimisation des modèles LLM pour la compréhension et le traitement des documents. Ils peuvent également expérimenter la mise en œuvre de services d'optimisation de modèles VLM en environnement périphérique et solliciter une consultation gratuite.

Un représentant de Nota a déclaré : « Cette exposition est conçue pour permettre aux visiteurs de découvrir directement comment la technologie d'optimisation par IA peut être mise en œuvre efficacement sur les appareils existants », et a ajouté : « Grâce à cette expérience, ils pourront mieux comprendre la technologie d'allègement et d'optimisation par IA et confirmer l'applicabilité de nos produits. »

- Voir plus d'articles connexes

You must be logged in to post a comment.